São Paulo — InkDesign News —

O uso de machine learning em aplicações de Modelos de Linguagem de Grande Escala (LLMs) está crescendo rapidamente, mas a validação e a avaliação de suas saídas são temas frequentemente subestimados. Garantir a robustez e o alto desempenho dessas aplicações é essencial.

Arquitetura de modelo

Em um cenário onde um LLM responde corretamente 999 em 1000 vezes, a implementação de backfilling em 1,5 milhão de itens resulta em 1.500 erros só para esse prompt. Esse é um desafio comum, especialmente ao escalar para várias prompts, o que pode complicar ainda mais a performance do modelo.

Um dos problemas identificados é a qualidade dos dados de entrada. Questões como dados ausentes e casos extremos não tratados compromete a eficácia do LLM. Dessa forma, é vital contar com um sistema que valide as saídas em tempo real, minimizando erros.

Treinamento e otimização

Utilizar uma estrutura de validação simples, como um if-else, é uma das maneiras de otimizar o desempenho dos modelos. Por exemplo, ao gerar um resumo de documentos, é crucial que o output possua um comprimento mínimo. O código pode ser estruturado para validar a qualidade do resumo gerado, como segue:

# Geração de resumo através de um cliente LLM

resumo = llm_client.chat("Faça um resumo deste documento {document}")

# Função de validação

def validar_resumo(resumo: str) -> bool:

if len(resumo)

Assim, se a validação falhar, há a opção de ignorar a solicitação ou implementar um mecanismo de repetição. Essa abordagem não só melhora a acurácia, mas também aumenta a confiabilidade das respostas geradas.

“Se a validação falhar, você pode optar por ignorar a solicitação ou escolher um mecanismo de repetição.”

(“If it fails, you can choose to ignore the request or utilize a retry mechanism.”)— Autor, Especialista em AI

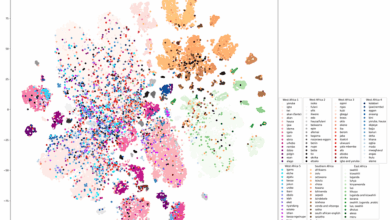

Resultados e métricas

As avaliações quantitativas das saídas dos LLMs são igualmente essenciais. Elas devem ser realizadas periodicamente. A combinação dessas avaliações com feedback qualitativo pode fornecer insights valiosos sobre a performance do modelo. Por exemplo, se as métricas revelarem que os resumos gerados são mais longos do que o preferido pelos usuários, uma análise manual dessas saídas pode revelar as causas subjacentes.

A utilização de outro LLM como avaliador pode trazer uma visão mais detalhada da qualidade da saída, permitindo notas de 1 a 10, facilitando a identificação de resumos de qualidade média. É fundamental, entretanto, considerar os custos envolvidos nesse processo.

“A validação é uma tarefa mais simples do que gerar uma resposta correta.”

(“Validating correctness is usually a more straightforward task than generating a correct response.”)— Autor, Especialista em AI

O feedback do usuário também pode ser uma ferramenta valiosa para coletar métricas quantitativas sobre as saídas do LLM. Permitir que os usuários avaliem as respostas com um botão de positivo ou negativo pode gerar dados significativos para melhorar o desempenho do modelo.

Voltando-se a futuras aplicações, a pesquisa em validação e avaliação de LLMs promete continuar a evoluir, com um foco crescente em métodos de feedback contínuo e adaptações de algoritmos para aumentar a eficácia operacional.

Fonte: (Towards Data Science – AI, ML & Deep Learning)