São Paulo — InkDesign News — Análises recentes revelam que usuários do ChatGPT compartilharam dados sensíveis, revelações de vida pessoal e procuraram aconselhamento em questões de saúde mental, expondo vulnerabilidades relacionadas à privacidade antes do vazamento de informações em agosto de 2025.

Incidente e vulnerabilidade

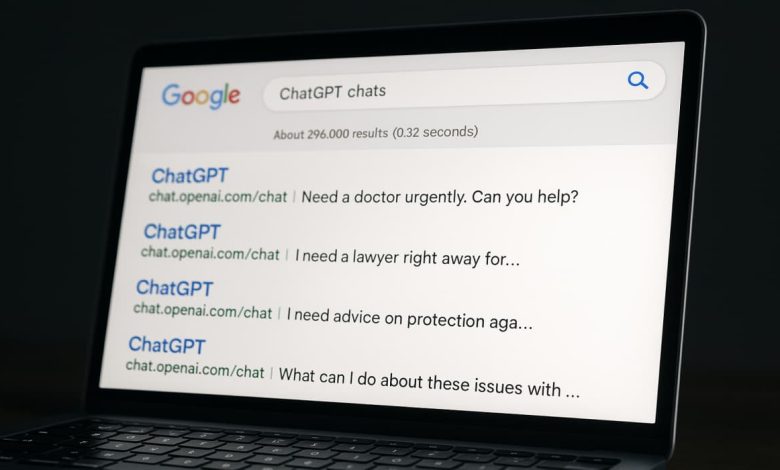

Em agosto de 2025, uma falha no design do produto do ChatGPT permitiu que conversas privadas fossem tornadas públicas, resultando no vazamento de milhares de interações de usuários. Essa vulnerabilidade, relacionada ao recurso que tornava chats “descobertos”, ativou a indexação das conversas por mecanismos de busca, enquanto os usuários, sem entender completamente os riscos, tratavam o chatbot como uma plataforma segura para compartilhar informações pessoais. O estudo realizado pela SafetyDetective analisou 1.000 dessas conversas e a extensividade dos dados compartilhados, que totalizavam mais de 43 milhões de palavras.

Impacto e resposta

Os dados expostos incluíam informações identificáveis pessoalmente, como nomes completos, endereços, números de telefone e currículos, além de tópicos sensíveis sobre saúde mental e situação familiar. A pesquisa destacou que 60% das conversas foram categorizadas como “consultas profissionais”, onde os usuários buscavam conselhos que normalmente procurariam de profissionais qualificados. “Em um caso, a IA espelhou o estado emocional de um usuário durante uma conversa sobre vícios, escalando em vez de desescalar o tom.”

(“In one case, the AI mirrored a user’s emotional state during a conversation about addiction, escalating rather than de-escalating the tone.”)

— Shipra Sanganeria, SafetyDetective

Mitigações recomendadas

A SafetyDetective recomenda que os usuários evitem compartilhar dados sensíveis em conversas com chatbots, independentemente de como a interface pareça privada. Além disso, as empresas de IA devem tornar mais claras as advertências e melhorar a interface dos recursos de compartilhamento. A implementação de mecanismos automáticos para redigir informações pessoais antes que uma conversa seja compartilhada poderia reduzir a probabilidade de vazamentos acidentais. “Até que plataformas de IA ofereçam proteções de privacidade mais robustas e os usuários sejam mais cuidadosos com o que compartilham, será complicado distinguir entre uma conversa privada e algo que pode se tornar público.”

(“Until AI platforms offer stronger privacy protections and people are more careful with what they share, it will be hard to tell the difference between a private chat and something that could end up public.”)

— Análise de Segurança

Riscos residuais permanecem, uma vez que a confiança excessiva em sistemas de IA não é acompanhada de garantias de privacidade. A próxima etapa exige um compromisso contínuo com a segurança dos dados e a consciência dos usuários sobre o que são adequados para compartilhar.

Fonte: (Hack Read – Segurança Cibernética)