São Paulo — InkDesign News — No campo de machine learning, a otimização e a arquitetura de modelos são essenciais para o sucesso em aplicações de inteligência artificial. Recentes discussões sobre ferramentas como o Model Context Protocol (MCP) revelam lacunas na forma como APIs são expostas e geridas.

Arquitetura de modelo

O MCP é descrito como uma solução para a conexão entre aplicações de LLM e ferramentas externas. No entanto, sua abordagem "cima para baixo" pode resultar em uma superexposição de opções que prejudica a performance. O artigo enfatiza que, para modelos como o MCP, a prática de expor toda a superfície de uma API sem um filtro adequado é problemática, pois pode inchaçar os prompts e degradar a qualidade. A ideia central é que uma camada adicional, denominada tool masking, é necessária para otimizar a interação com modelos de linguagem.

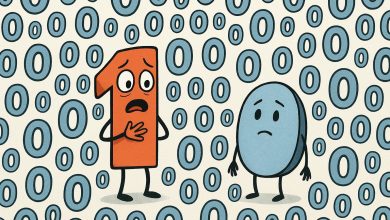

A exposição bruta de APIs gera custos: cada ferramenta adicionada incha os prompts e embaraça a execução.

(“Raw exposure of APIs comes at a cost: every tool surface pushed straight into an agent bloats prompts and drags down execution quality.”)— Frank Wittkampf, Autores do Artigo

Treinamento e otimização

Com a evolução das arquiteturas de aprendizado profundo, a necessidade de uma camada de mascaramento torna-se cada vez mais evidente. Ao invés de oferecer a complexidade total de uma API, a aplicação pode expor apenas o necessário, reduzindo a quantidade de tokens utilizados e aumentando a eficiência. Um exemplo prático é o uso de APIs financeiras. Ao receber dados excessivos de uma única chamada, o agente pode se sentir sobrecarregado, comprometendo a acurácia.

A solução real é que, com o mascaramento de ferramentas, você tem controle sobre a superfície apresentada ao seu agente.

(“Here’s the real unlock: with tool masking, you’re in control of the surface you present to your agent.”)— Lucas Vieira, Autores do Artigo

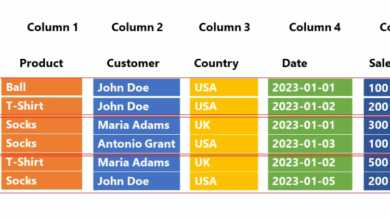

Resultados e métricas

Implementar uma estratégia de tool masking resulta em prompts menores e mais diretos, levando a respostas mais rápidas e precisas. Esta abordagem poderia ser particularmente benéfica para empresas que processam milhões de tokens por minuto, onde pequenas ineficiências podem causar grandes desperdícios. O estudo destaca que a escolha inadequada de ferramentas, em uma superfície de API ampla, leva a erros e baixa precisão.

O mascaramento de ferramentas é sobre projetar a interface correta voltada para o agente para a tarefa em questão.

(“The point: Tool masking is not just about hiding complexity. It’s about designing the right agent-facing surface for the job at hand.”)— Frank Wittkampf, Autores do Artigo

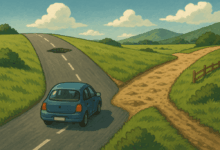

Para o futuro, é essencial investigar mais sobre como essas práticas podem ser aplicadas a diversas APIs. A necessidade de refinar a maneira como as informações são geridas em sistemas de machine learning promete impulsionar novas inovações e tornar as interações mais eficientes. Essa abordagem pode facilitar a criação de agentes que compreendam e utilizem dados de forma mais eficaz, refletindo novas direções na pesquisa de inteligência artificial.

Fonte: (Towards Data Science – AI, ML & Deep Learning)