São Paulo — InkDesign News —

Pesquisadores da Universidade Estadual da Carolina do Norte desenvolveram uma nova técnica de ataque a sistemas de visão computacional baseados em IA, chamada RisingAttacK. Esta abordagem tem como objetivo manipular o que a AI “vê” em imagens, apresentando implicações significativas para a segurança em aplicações críticas.

Contexto da pesquisa

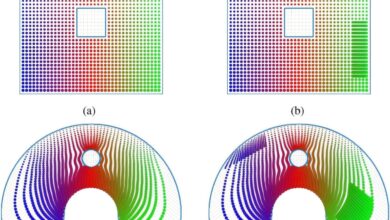

Os ataques adversariais são uma preocupação crescente nos sistemas de machine learning, onde dados manipulados podem levar a falhas graves em decisões automáticas. A nova técnica, RisingAttacK, busca explorar essas vulnerabilidades, identificando como diferentes modificações visuais podem afetar a precisão da detecção em sistemas de visão computacional amplamente utilizados.

Método proposto

RisingAttacK utiliza uma série de operações para realizar alterações mínimas em uma imagem, visando manipular os resultados da IA. O processo começa com a identificação de todas as características visuais presentes na imagem e determina quais são cruciais para o objetivo do ataque. A técnica então avalia a sensibilidade do sistema de IA às alterações nesses recursos essenciais. Esse método requer poder computacional significativo, permitindo aos pesquisadores realizar mudanças pontuais que podem ser invisíveis ao olho humano.

“Por exemplo, se o objetivo do ataque é impedir a IA de identificar um carro, quais características na imagem são mais importantes para essa identificação?”

(“For example,” says Wu, “if the goal of the attack is to stop the AI from identifying a car, what features in the image are most important for the AI to be able to identify a car in the image?”)— Tianfu Wu, Professor Associado, Universidade Estadual da Carolina do Norte

Resultados e impacto

Os pesquisadores testaram a RisingAttacK em quatro dos sistemas de visão computacional mais utilizados: ResNet-50, DenseNet-121, ViTB e DEiT-B, obtendo sucesso em manipular todos eles. “Isso significa que podemos influenciar a capacidade da IA de ver qualquer um dos 20 ou 30 principais alvos que foi treinada para identificar,” acrescenta Wu.

A pesquisa será apresentada em 15 de julho na Conferência Internacional de Aprendizado de Máquina (ICML 2025), em Vancouver, Canadá. Há um foco contínuo em descobrir como essa técnica pode ser aplicada a outros sistemas de IA, como modelos de linguagem.

Os próximos passos incluem o desenvolvimento de métodos que possam efetivamente defender esses sistemas contra tais ataques, visando melhorar a segurança em tecnologias que impactam diretamente a saúde e segurança humana.

Fonte: TechXplore – Machine Learning & AI