São Paulo — InkDesign News —

A recente pesquisa sobre machine learning revela como falhas em modelos de inteligência artificial (IA) podem oferecer uma compreensão mais profunda de seu funcionamento. A investigação se aprofunda nas implicações dos chamados “hallucinations” gerados por esses sistemas.

Contexto da pesquisa

No cenário atual, os modelos de aprendizado profundo, como os modelos de linguagem de grande escala (LLMs), estão cada vez mais sofisticados. Entretanto, as deficiências desses modelos estão se tornando um foco de preocupação e estudo por parte de acadêmicos em várias instituições no mundo. Pesquisadores argumentam que a análise das falhas pode oferecer insights valiosos para a melhoria e compreensão da IA.

Método proposto

Os pesquisadores propõem um método de investigação onde a criação intencional de entradas confusas para modelos de IA, como o Claude Sonnet 3.7, gera saídas inesperadas. Essa abordagem, chamada de “desconstrução criativa”, busca injetar incoerência nas respostas do modelo a fim de examinar suas estruturas internas.

A abordagem revela que a “falha do sistema” e a operação normal da IA são processos fundamentalmente semelhantes, apenas com diferentes níveis de coerência aplicados.

(“system failure” and the normal operation of AI are fundamentally the same process, just with different levels of coherence imposed on top.)— Daniel Binns, Pesquisador

Resultados e impacto

Os resultados mostraram que quando induzidos a estados de colapso semântico, os modelos expõem suas limitações e viés de treinamento de maneira mais evidente. A pesquisa também sugere que esses “hallucinations”, ou saídas incoerentes, são parte integral do processo criativo do modelo e não falhas propriamente ditas.

Quando a IA “halucina”, não está defeituosa; está demonstrando a mesma incerteza criativa que a capacita a gerar algo novo.

(“when AI hallucinates, it’s not malfunctioning; it’s demonstrating the same creative uncertainty that makes it capable of generating anything new at all.”)— Daniel Binns, Pesquisador

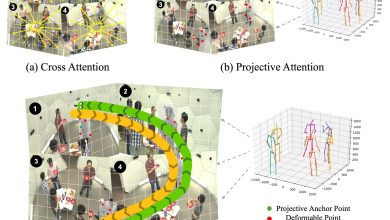

Essa investigação se baseou em diversos datasets e benchmarks, buscando entender como os modelos processam informações visuais e textuais. O impacto deste estudo poderá ser significativo na evolução dos sistemas de IA, com implicações para modelos futuros que priorizem a adaptabilidade e a resiliência diante de dados complexos e ambíguos.

Possíveis aplicações incluem a utilização dessas descobertas para informar o design de modelos de IA mais robustos e com maior capacidade de entendimento em situações de ambiguidade, além de métodos educacionais que aumentem a alfabetização crítica em IA.

Fonte: (TechXplore – Machine Learning & AI)