São Paulo — InkDesign News —

A pesquisa recente revela que a inteligência artificial (IA) pode desenvolver sentimentos como culpa, mas apenas em ambientes sociais específicos. O estudo utiliza teoria dos jogos para explorar a evolução da culpa em sistemas multiagentes, destacando implicações para decisões éticas em máquinas.

Contexto da pesquisa

A culpa é uma qualidade vantajosa para a sociedade, permitindo que os indivíduos reconheçam erros e promovam cooperação. À medida que interagimos mais com sistemas de IA, a necessidade de incorporar uma tomada de decisão ética se torna crítica. O estudo, publicado no Journal of the Royal Society Interface, apresenta um modelo de teoria dos jogos para analisar quando e como a culpa pode evoluir em agentes artificiais.

Método proposto

Os pesquisadores utilizaram o “dilema dos prisioneiros”, onde dois jogadores têm que escolher entre cooperar ou trair. O estudo investigou como essas decisões se alteram em diferentes redes sociais: bem misturadas, homogeneas e heterogeneas. A análise diferenciava entre culpa social, que requer consciência das ações dos outros, e culpa não social, focada no indivíduo.

Resultados e impacto

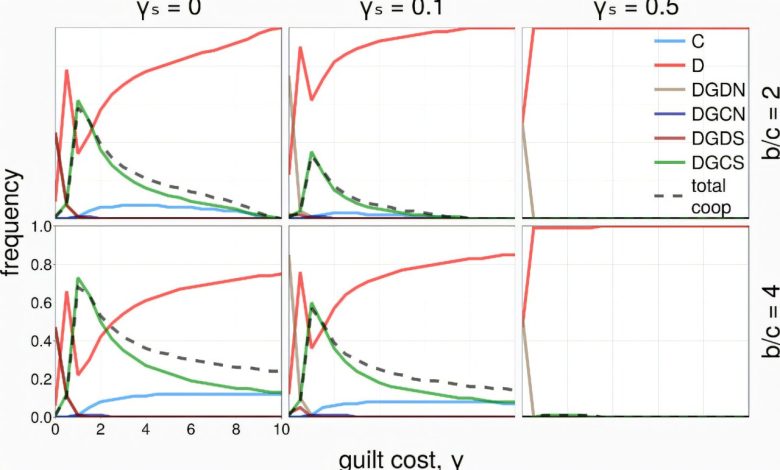

Os resultados mostraram que tanto a culpa social quanto a não social evoluíram em populações estruturadas. A culpa não social era mais suscetível à exploração por agentes não culpados, mas persistiu quando agrupada com estratégias emocionalmente similares. “A cooperação não surge quando os agentes apenas aliviam sua própria culpa… A tendência de aliviar a culpa deve ser mútua para que a cooperação prospere” (

“Cooperação não surge quando agentes apenas aliviam sua própria culpa… A tendência de aliviar a culpa deve ser mútua para que a cooperação prospere.”

(“Cooperation does not emerge when agents only alleviate their own guilt… The tendency to alleviate guilt must be mutual for cooperation to thrive.”)— Theodor Cimpeanu, Autor, Journal of the Royal Society Interface

).

Esses achados oferecem insights sobre como integrar a culpa e a cooperação ética em sistemas de IA, possibilitando uma aplicação mais ampla de modelos que considerem interações sociais. Pesquisas futuras poderiam expandir esses conceitos em ambientes mais complexos e menos previstos.

Fonte: (TechXplore – Machine Learning & AI)