São Paulo — InkDesign News — A construção de memórias eficientes em sistemas de machine learning, especialmente em modelos de linguagem natural (LLMs), é um desafio que especialistas estão explorando ativamente.

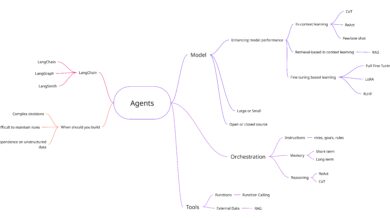

Arquitetura de modelo

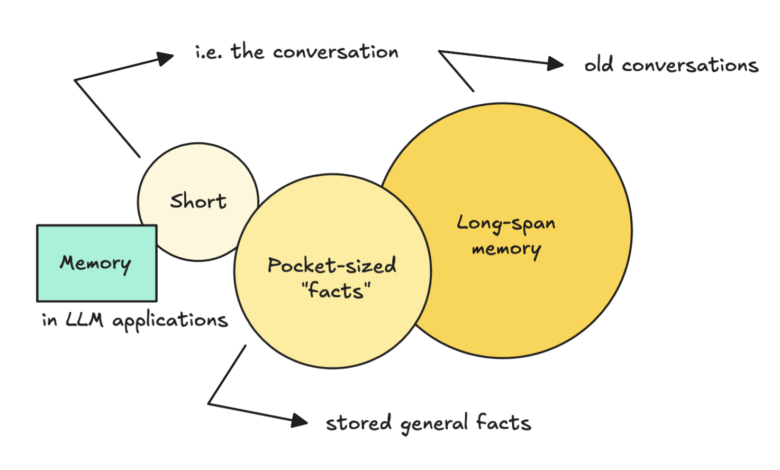

Os sistemas de memória em LLMs podem ser organizados em duas partes principais: factos pequenos, ou “pocket-sized facts”, e memória de longo prazo, que armazena conversas anteriores. A abordagem inicial para resolver a questão da memória é muitas vezes a utilização de um banco de dados de vetores, que permite que o modelo armazene e busque informações relevantes.

“A estratégia inicial pode ser simplesmente armazenar todas as mensagens e tentar buscar as relevantes, mas isso pode levar à confusão devido à sobrecarga de informações.” (“The initial strategy may be to simply store all messages and try to fetch the relevant ones, but this can lead to confusion due to information overload.”) — Especialista em IA

Treinamento e otimização

Para aprimorar a precisão, é essencial implementar técnicas de atualização e edição de memórias. Uma solução possível é o uso de grafos de conhecimento (KGs), que permitem que o modelo relate informações em uma rede de entidades e suas relações. Ao incorporar timestamps, o sistema se torna capaz de realizar raciocínios temporais e fornecer dados atualizados.

“Grafos de conhecimento podem fornecer uma estrutura que facilita a recuperação e a atualização de fatos, permitindo assim um raciocínio mais complexo.” (“Knowledge graphs can provide a structure that facilitates the retrieval and updating of facts, thereby enabling more complex reasoning.”) — Pesquisador em IA

Resultados e métricas

As soluções atualmente disponíveis variam entre bancos de dados de vetores e grafos de conhecimento, cada uma com seus próprios desafios e vantagens. Embora abordagens baseadas em vetores sejam geralmente mais simples e rápidas de implementar, elas podem lidar mal com informações conflitantes. Por outro lado, KGs oferecem mais robustez em situações de raciocínio envolvendo múltiplos saltos e conexões temporais.

“A complexidade da infraestrutura frequentemente aumenta com o crescimento de um grafo de conhecimento.” (“Infrastructure complexity often increases with the growth of a knowledge graph.”) — Engenheiro de Dados

Os desenvolvimentos na área ainda são incipientes, e muitos pesquisadores se dedicam a descobrir métodos que integrem eficiências de processamento e a capacidade de resolver problemas complexos de memória. As duas abordagens — vetores e grafos de conhecimento — podem ser combinadas para otimizar o sistema de memória.

O uso de memórias em sistemas de LLM pode impactar áreas como assistentes virtuais, recomendação de conteúdos e análise de sentimentos, oferecendo um horizonte promissor para aplicações futuras.

Fonte: (Towards Data Science – AI, ML & Deep Learning)