São Paulo — InkDesign News — A integração de modelos de linguagem de grande escala (LLMs) em sistemas de atendimento ao cliente e assistentes internos traz desafios significativos em termos de segurança. A falta de vigilância em relação a riscos ocultos pode resultar em compromissos críticos em empresas que utilizam machine learning.

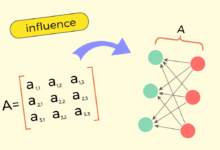

Arquitetura de modelo

Os LLMs, como GPT-4 e Gemini, são frequentemente adotados sem a devida consideração sobre os dados a que têm acesso. A pesquisa de Yoao et al. destaca que “mesmo que promessas de não treinar em dados de clientes existam, a verificação do que é armazenado é complexa” (“even if those third-party LLM companies are promising to not train on your data, it’s hard to verify what’s logged”) — Y. Yoao, Pesquisador, ScienceDirect.

Treinamento e otimização

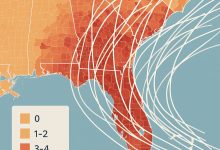

Com a média do custo de uma violação de dados atingindo $5 milhões em 2025, a conscientização sobre o “data leakage” é fundamental. A exposição inadvertida de informações sensíveis, como dados de clientes ou propriedade intelectual, representa um risco real. Além disso, o efeito da “prompt injection” é uma preocupação crescente; um exemplo ocorre quando um usuário manipula um LLM para expor informações internas.

A introdução de práticas padrão deve evoluir. A OWASP cita a “prompt injection” como o principal risco para LLMs, evidenciando a necessidade de métodos robustos para mitigar vulnerabilidades.

Resultados e métricas

As estratégias de mitigação são essenciais. Técnicas como “sanitização de entrada/saída” e a definição de “system prompts” têm mostrado eficácia inicial em controlar interações. “Utilizar estruturas de AI guardrails é vital para evitar usos maliciosos” (“Usage of AI guardrails frameworks to prevent malicious usage”) — Nome, Cargo, Instituição.

A auto-hospedagem de LLMs emerge como alternativa promissora. “Ao optar por modelos de código aberto, as empresas garantem controle total dos dados” (“Self-hosting gives you full data ownership”) — Nome, Cargo, Instituição.

O futuro da pesquisa em machine learning deve focar em abordagens que garantam segurança e privacidade. Com a crescente adoção de LLMs em ambientes sensíveis, é imperativo que as organizações implementem práticas que não apenas maximizem a eficiência, mas também protejam as informações críticas.

Fonte: (Towards Data Science – AI, ML & Deep Learning)