A nova ameaça às marcas d’água na era da IA

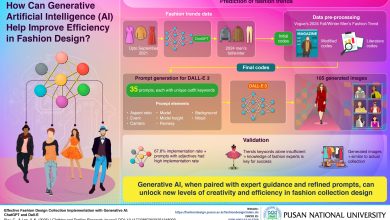

Machine learning e inteligência artificial (IA) estão revolucionando diversos campos, mas pesquisas recentes indicam que as soluções atuais para proteção de conteúdo gerado por IA, como marcas d’água, são suscetíveis a ataques.

Contexto da pesquisa

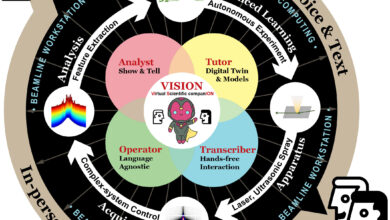

Pesquisadores do Universidade de Waterloo investigaram a vulnerabilidade das marcas d’água em imagens geradas por IA, revelando que esses sistemas de segurança podem ser facilmente comprometidos. Com a evolução de deepfakes e outras tecnologias, a necessidade de identificação de conteúdo verdadeiro torna-se cada vez mais urgente.

Método proposto

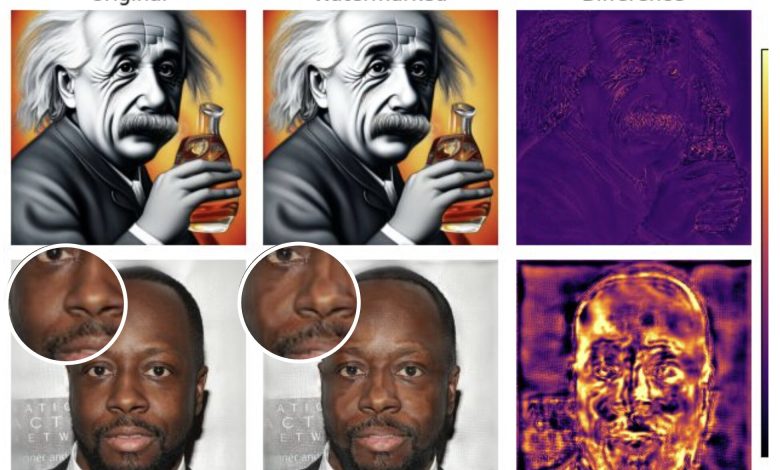

A equipe desenvolveu uma ferramenta chamada UnMarker, que utiliza ataques estatísticos para remover marcas d’água de imagens sem precisar conhecer o algoritmo de marcação. O princípio por trás do UnMarker é explorar anomalias na frequência de pixels, distorcendo essas frequências e tornando a imagem irreconhecível para a ferramenta de reconhecimento de marcas, mas mantendo-a visualmente intacta.

Resultados e impacto

Em testes realizados, o método demonstrou eficácia superior a 50% ao aplicar-se em modelos de IA renomados, como o SynthID da Google e o Stable Signature da Meta, sem qualquer informação prévia sobre os métodos de marcação utilizados. Isso levanta sérias preocupações sobre a confiabilidade das soluções de watermarking atualmente oferecidas pelas empresas de tecnologia.

“Se conseguimos descobrir isso, também conseguirão atores maliciosos. A marcação está sendo promovida como a solução perfeita, mas mostramos que essa tecnologia é quebrável.”

(“If we can figure this out, so can malicious actors. Watermarking is being promoted as this perfect solution, but we’ve shown that this technology is breakable.”)— Andre Kassis, Candidato a Ph.D., Universidade de Waterloo

Com a crescente presença de deepfakes e a dificuldade em distinguir entre conteúdos reais e gerados artificialmente, a pesquisa destaca a fragilidade das atuais abordagens de segurança. Especialistas alertam que a superexposição a conteúdos manipulados pode resultar em consequências sociais e legais significativas.

As implicações da pesquisa são vastas, sugerindo que novos métodos de identificação e autenticação de conteúdos precisam ser desenvolvidos para enfrentar esses desafios emergentes na era digital.

Fonte: (TechXplore – Machine Learning & AI)