Pesquisas recentes em machine learning têm revelado novas abordagens para decifrar os mecanismos que regem essa tecnologia, vital em setores como reconhecimento facial e veículos autônomos. Um estudo conduzido na Universidade de Utah propõe um novo modelo que explora as leis de escalabilidade em sistemas de aprendizado de máquina.

Contexto da pesquisa

Com a crescente dependência da sociedade em relação a inteligência artificial (AI), a necessidade de entender como modelos de machine learning operam se torna cada vez mais evidente. Zhengkang (Kevin) Zhang, professor assistente do Departamento de Física e Astronomia da Universidade de Utah, estou se dedicando a investigar as complexidades por trás desses modelos, que tradicionalmente são vistos como caixas-pretas.

“As pessoas costumavam dizer que o machine learning é uma caixa preta — você insere muitos dados e, em algum momento, ele raciocina e toma decisões como os humanos. Parece mágica porque não sabemos exatamente como funciona.”

(“People used to say machine learning is a black box—you input a lot of data and at some point, it reasons and speaks and makes decisions like humans do. It feels like magic because we don’t really know how it works.”)— Zhengkang Zhang, Professor Assistente, Universidade de Utah

Método proposto

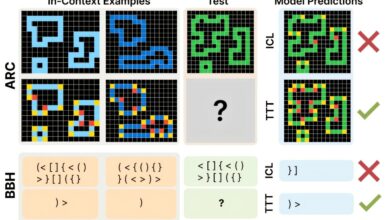

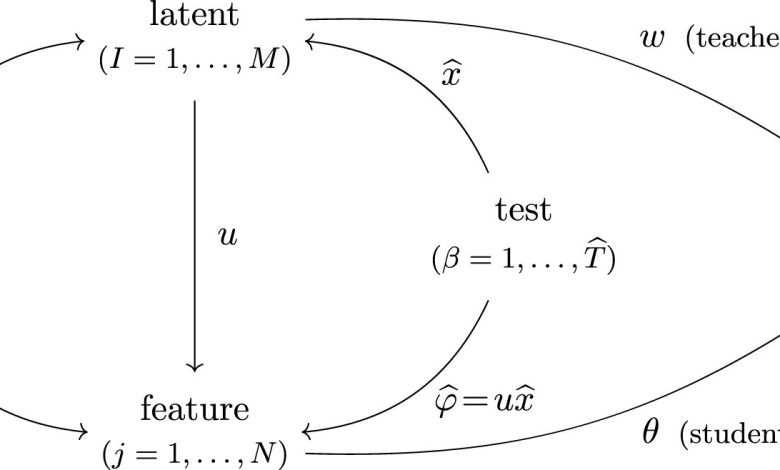

Zhang aplicou técnicas utilizadas na física de partículas, especificamente diagramas de Feynman, para ilustrar as relações em modelos de machine learning, que geralmente são compostos por redes neurais complexas. Essa abordagem permite visualizar e analisar as operações que afetam o aprendizado sem depender de tentativas e erros dispendiosas, visando entender como diferentes variáveis influenciam o desempenho do modelo.

Resultados e impacto

No novo artigo publicado na revista Machine Learning: Science and Technology, Zhang demonstrou como as leis de escalabilidade podem ser aplicadas para prever a eficiência de modelos em maiores escalas. Ao resolver um modelo através de métodos matemáticos avançados, obteve-se novas leis de escalabilidade que governam o comportamento destes sistemas. Essa pesquisa se destaca pela capacidade de lidar com a complexidade intrínseca de cálculos que lidam com uma infinidade de termos.

“Quero entender melhor o que realmente está acontecendo para evitar depender de tentativas e erros.”

(“I would like to understand better what is really going on to avoid relying on trial and error.”)— Zhengkang Zhang, Professor Assistente, Universidade de Utah

Essas descobertas não apenas contribuem para a base teórica de machine learning, mas também têm implicações práticas no desenvolvimento de sistemas de AI mais robustos e compreensíveis. Zhang enfatiza a importância de envolver físicos e cientistas em um diálogo com engenheiros para utilizar a AI de maneira responsável.

As próxima etapas envolvem maior exploração desses modelos em cenários do mundo real, aumentando a transparência e a eficiência no aprendizado de máquina, um passo crucial à medida que o uso de AI continua a expandir.

Fonte: (TechXplore – Machine Learning & AI)