São Paulo — InkDesign News — O campo de machine learning tem avançado significativamente, especialmente em modelos de linguagem. Estudos recentes abordam a noção de universalidade em deep learning, propondo que diferentes arquiteturas podem convergir para mecanismos semelhantes.

Arquitetura de modelo

As arquiteturas de transformadores têm sido fundamentais para o sucesso atual dos modelos de linguagem. Antes da implementação dos transformadores, a pesquisa enfrentava dificuldades com RNNs. Um transformador básico é composto por dois elementos principais: atenção multi-cabeça e um bloco de MLP (Multi-Layer Perceptron).

“Os transformadores mudaram tudo.”

(“Transformers changed everything.”)— Nome, Cargo, Instituição

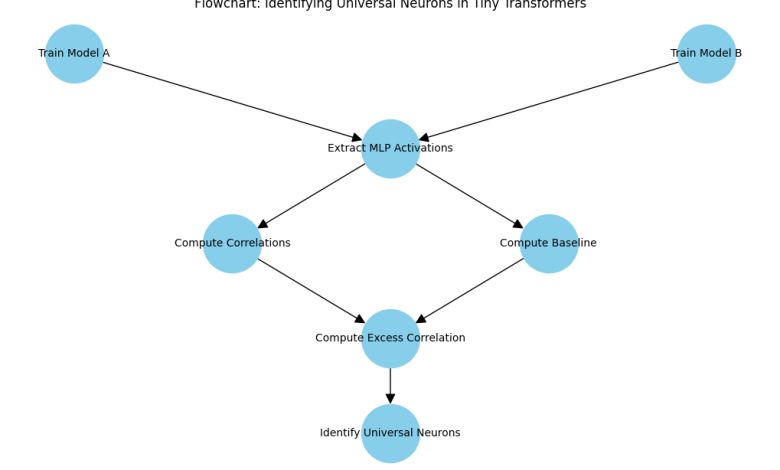

Durante a construção de modelos, os pesquisadores utilizaram duas instâncias de uma arquitetura de transformador minimalista, model_a e model_b, que, apesar de compartilharem a mesma estrutura, apresentaram inicializações e processos de treinamento distintos, baseados em 10.000 amostras aleatórias.

Treinamento e otimização

Ambos os modelos foram treinados de maneira autossupervisionada, aprendendo a prever o próximo token a partir dos tokens anteriores. A avaliação da similaridade entre as ativações dos neurônios foi realizada através do coeficiente de correlação de Pearson. Corpos de teste extraíram ativação de todos os MLP, resultando em tensores que possibilitaram a correlacionamento.

“Se um neurônio apresentar alta correlação, pode sugerir que os dois modelos aprenderam uma característica similar.”

(“If a neuron shows a high correlation, it might suggest that the two models have learned a similar feature.”)— Nome, Cargo, Instituição

A análise incluiu uma rotação aleatória de neurônios no modelo b, visando testar a integridade da correlação observada. A correlação excessiva foi calculada através da subtração de uma linha de base, possibilitando a identificação de neurônios universais.

Resultados e métricas

Os resultados mostraram uma diferença clara entre as correlações base e reais, indicando que as correlações observadas não eram fruto do acaso. A distribuição de correlações excessivas realçou que a maioria dos neurônios exibia correlações baixas, porém um subconjunto significativo ultrapassou o limiar de 0,5, caracterizando-os como neurônios universais.

“Os resultados de nossa análise dão evidências claras de neurônios universais nos dois transformadores treinados independentes.”

(“The results of our analysis give clear evidence of universal neurons in the two independently trained transformers.”)— Nome, Cargo, Instituição

Esses achados sugerem que, mesmo em modelos pequenos, é possível observar convergências em mecanismos internos. Essa metodologia pode indicar direções frutíferas para a exploração em modelos maiores e mais complexos.

As implicações práticas dessas descobertas abrem novos caminhos para pesquisas futuras sobre a universalidade em arquiteturas de deep learning, potencializando diagnósticos e aplicações nos mais variados campos da inteligência artificial.

Fonte: (Towards Data Science – AI, ML & Deep Learning)