São Paulo — InkDesign News — Um novo estudo explora como técnicas de machine learning podem aprimorar a adaptação de modelos a novos dados durante a fase de teste, potencializando a memória e eficiência em aprendizado.

Arquitetura de modelo

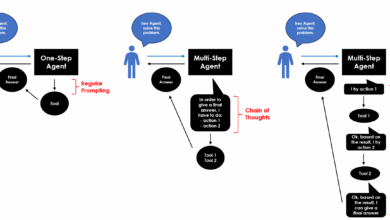

A pesquisa, colaborativa entre o Meta, Stanford e Berkeley, propõe um framework chamado Meta-Test-Time Training (MTTT). Nesse modelo, a estrutura é dividida em dois laços: um laço externo que orienta o treinamento principal e um laço interno que ajusta os pesos do modelo para tarefas específicas e auto-supervisionadas.

“Isso significa que agora o modelo não só pode treinar em dados de teste, mas também escolher como esses dados de teste devem ser usados para se treinar!”

(“This means that now the model can not only train on test data, but also choose how that test data is to be used to train itself!”)— Yu Sun, Pesquisador, Meta

Treinamento e otimização

O laço externo age como um “meta-professor”, criando um currículo para o laço interno otimizar as tarefas de teste. A técnica transforma o processo de treinamento em uma função diferenciável única, permitindo otimização completa. Os pesos iniciais são ajustados em resposta a um conjunto definido de dados, estabelecendo o laço interno como um adaptador eficiente das condições de teste.

“A arte de projetar tarefas de TTT tem se mostrado vulnerável a falácias humanas, isto é, os modelos podem aprender erroneamente de maneira contra-produtiva.”

(“The art of designing TTT tasks has proven vulnerable to human fallacies, that is, models can learn incorrectly in a counterproductive way.”)— Ali Behrouz, Pesquisador, Stanford

Resultados e métricas

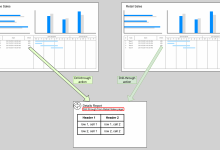

O MTTT-MLP foi testado em dois cenários no conjunto de dados ImageNet. No primeiro, utilizando imagens padrão, o modelo alcançou 74,6% de acurácia, superando suas versões anteriores. No segundo, ao utilizar pixels brutos, o MTTT-MLP demonstrou robustez, registrando 61,9% enquanto seus concorrentes falharam devido a limitações de memória.

“Esses resultados indicam que, embora a autoatenção apresente um desempenho superior em tarefas padrão, o MTTT-MLP oferece um aumento significativo na capacidade de modelagem sob restrições severas.”

(“These results indicate that while self-attention shows superior performance in standard tasks, MTTT-MLP provides a significant increase in modeling ability under severe constraints.”)— Yu Sun, Pesquisador, Meta

As aplicações práticas do MTTT-MLP podem ser amplas, abrangendo desde a visão computacional até tarefas de classificação em cenários de dados não estruturados. Futuras pesquisas podem explorar ainda mais abordagens para aumentar a eficiência em ambientes dinâmicos e complexos.

Fonte: (Towards Data Science – AI, ML & Deep Learning)