Redes neurais aumentam o risco de imagens explícitas não consensuais

São Paulo — InkDesign News —

Pesquisadores da Universidade da Flórida alertam sobre um aumento preocupante na geração de imagens sexualmente explícitas por meio de inteligência artificial (AI) sem o consentimento dos indivíduos retratados. Este fenômeno, descrito como SNEACI (synthetic non-consensual explicit AI-created imagery), levanta questões sobre a ética e a regulamentação dessas tecnologias emergentes.

Contexto da pesquisa

A equipe de pesquisa da Universidade da Flórida, em parceria com instituições como a Universidade de Georgetown e a Universidade de Washington, investiga ferramentas que permitem a geração de imagens realistas a partir de fotos carregadas. O professor Kevin Butler, que lidera a pesquisa, expressa preocupação com a acessibilidade e a falta de regulamentação, afirmando: “Qualquer um pode fazer isso” (“Anybody can do this”)

— Kevin Butler, Professor, Universidade da Flórida.

Método proposto

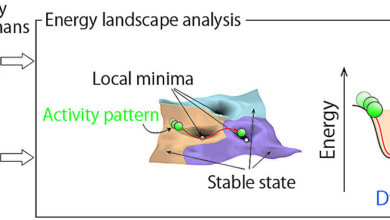

No estudo, os pesquisadores analisaram 20 sites de “nudificação” que permitem aos usuários manipular imagens, alterando roupa, forma do corpo e pose, gerando fotos sexualmente explícitas em questão de segundos. Esses sites utilizam tecnologias de deep learning e, muitas vezes, redes adversariais generativas (GANs) para criar imagens que são quase indistinguíveis das originais.

Apesar de alguns sites apresentarem termos de serviço que afirmam exigir que os sujeitos das imagens sejam maiores de 18 anos, a maioria não implementou verificações de idade eficazes, contribuindo para um ambiente não regulamentado. Somente 7 dos 20 sites estudados incluíram tais cláusulas.

Resultados e impacto

Os pesquisadores documentaram que as tecnologias estão sendo usadas desproporcionalmente contra mulheres, mas que também podem ser direcionadas a qualquer pessoa, inclusive crianças. Não foram encontrados salvaguardas técnicas que impedissem seu uso inadequado. Butler destacou: “Essas imagens não são criadas apenas por diversão” (“These images aren’t just created for amusement”)— elas são usadas para embaraçar, humilhar e até extorquir vítimas

— Kevin Butler, Professor, Universidade da Flórida.

As implicações sociais desse fenômeno são devastadoras, afetando a saúde mental das vítimas. Butler e sua equipe continuam explorando o impacto desta tecnologia e a necessidade de regulamentação, buscando oferecer insights técnicos para legislações mais eficazes.

As pesquisas futuras se concentrarão na avaliação de ferramentas de AI e em propostas para limitar seu uso indevido, além de contribuir para uma discussão mais ampla sobre a responsabilidade social na aplicação de tecnologias de machine learning.

Fonte: (TechXplore – Machine Learning & AI)