São Paulo — InkDesign News —

A pesquisa recente sobre machine learning revela uma vulnerabilidade em sistemas de reconhecimento de imagem, com implicações significativas para a inteligência artificial (AI) e a segurança automotiva.

Contexto da pesquisa

A pesquisa foi conduzida por Qiang Zeng, professor associado do Departamento de Ciência da Computação da George Mason University, e seu aluno de doutorado Xiang Li, entre outros colaboradores. O foco da pesquisa está na possibilidade de um atacante comprometer a interpretação de sistemas de AI ao modificar um único bit de dados em imagens, o que pode provocar sérios problemas de segurança, especialmente em veículos autônomos.

Método proposto

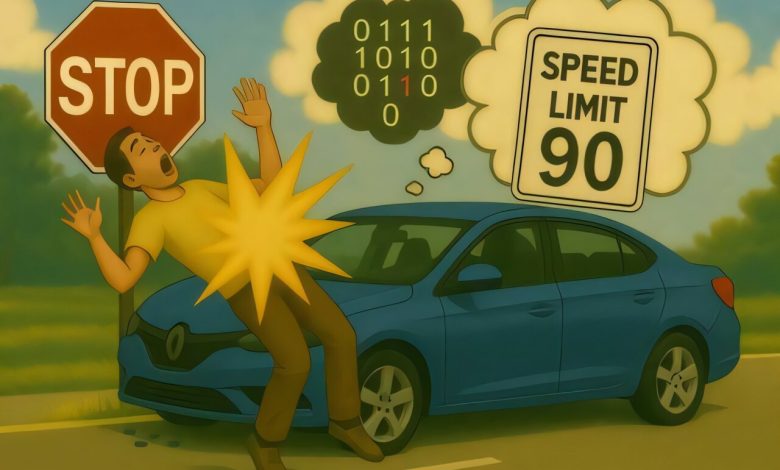

Os pesquisadores desenvolveram a abordagem chamada “OneFlip”, que permite a um atacante alterar a interpretação de imagens por sistemas de AI, como veículos autônomos. Ao “virar” apenas um bit, o atacante pode fazer com que um sinal de parada seja reconhecido como um limite de velocidade. Este método explora redes neurais profundas (DNNs), que são fundamentais em sistemas de AI e trabalham com centenas de bilhões de bits. A mudança de um bit é considerada discreta e, portanto, extremamente difícil de detectar.

“Um atacante pode alterar apenas um bit, e essa mudança permite que um patch seja anexado a qualquer imagem e enganar o sistema de AI.”

(“An attacker can selectively flip only one bit, and this changing of the bit from 0 to 1 allows an attacker to attach a patch onto any image and fool the AI system.”)— Qiang Zeng, Professor Associado, George Mason University

Resultados e impacto

Durante os testes, a taxa de sucesso da técnica foi próxima de 100%. O método não necessita de adaptações específicas para cada imagem, já que usa um patch uniforme que pode induzir a múltiplas interpretações errôneas de sinais. Esta abordagem cria uma ameaça nova e significativa, já que a maioria dos sistemas DNN pode ser suscetível a esse tipo de manipulação. Os pesquisadores ressaltam que o acesso aos pesos do modelo e a capacidade de executar código no ambiente de hospedagem são requisitos para a realização do ataque, o que limita potencialmente a exploração em cenários dantes de segurança.

A pesquisa sugere que a vulnerabilidade pode não se restringir apenas a sinais de trânsito, mas também a sistemas de reconhecimento de fala e outras aplicações de AI. O próximo passo consistirá na exploração das implicações mais amplas dessa técnica, buscando proteger os sistemas contra esse tipo de ataque.

Fonte: (TechXplore – Machine Learning & AI)