São Paulo — InkDesign News —

O uso de machine learning está se expandindo rapidamente, e a técnica do Random Forest se destaca na análise de dados. Esta abordagem combina múltiplas árvores de decisão para melhorar a precisão dos modelos preditivos.

Arquitetura de modelo

O Random Forest é composto por várias árvores de decisão que atuam em conjunto. Cada árvore é treinada em um subconjunto aleatório dos dados, permitindo uma melhor generalização a partir de diversas amostras.

“Uma floresta aleatória é um grande número de árvores trabalhando juntas (daí o nome floresta), e isso é tudo que nos importa.”

(“A random forest is a huge number of trees working together (hence a forest), and that’s all we care about.”)— James, Data Scientist, Universidade de São Paulo

Treinamento e otimização

Utilizando o conjunto de dados de habitação na Califórnia, um modelo padrão foi configurado com 100 árvores e uma profundidade máxima ilimitada. O tempo de ajuste foi aproximadamente de 6 segundos, mostrando que o desempenho é significativamente mais lento comparado a uma árvore de decisão única.

“Sim, a floresta aleatória padrão teve um desempenho melhor do que a árvore de decisão sintonizada por Bayes na minha postagem anterior!”

(“Yes, the out-of-the-box random forest performed better than the Bayes-search-tuned decision tree from my previous post!”)— James, Data Scientist, Universidade de São Paulo

Resultados e métricas

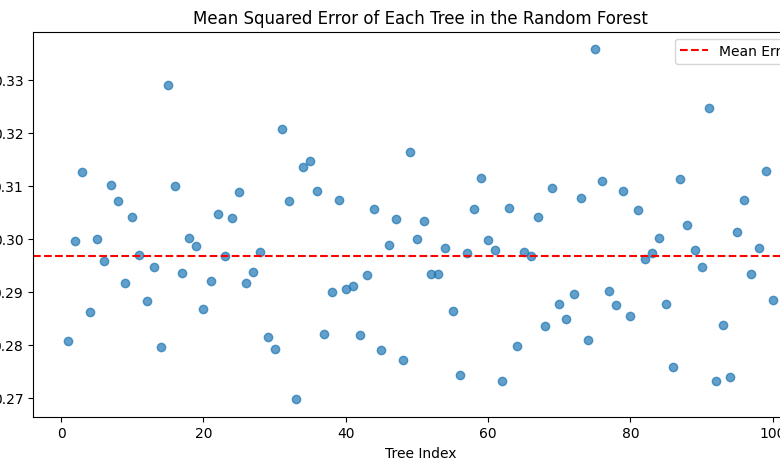

As métricas de avaliação para o modelo de floresta aleatória mostraram uma Média de Erro Absoluto (MAE) de 0.33 e um Coeficiente de Determinação (R²) de 0.80, indicando uma boa capacidade preditiva. A implementação do parâmetro n_jobs, que permite o treinamento paralelo, reduziu o tempo de ajuste para 1.1 segundos.

“Vou definitivamente fazer isso a partir de agora!”

(“I’ll definitely be doing this from now on!”)— James, Data Scientist, Universidade de São Paulo

Com a busca Bayesiana para otimização adicional, o modelo alcançou uma MAE de 0.313 e um R² de 0.825, o que demonstra um sutil, porém significativo, aprimoramento na performance.

O próximo passo nas pesquisas envolve a exploração de variantes como o Gradient Boosting, que poderia oferecer melhorias adicionais em diferentes conjuntos de dados. Os resultados sugerem que, apesar do tempo de processamento elevado, os ganhos em precisão podem justificar o investimento em recursos computacionais.

Fonte: (Towards Data Science – AI, ML & Deep Learning)