São Paulo — InkDesign News — A aplicação de técnicas de machine learning, como as utilizadas em redes neurais, está revolucionando diversos setores, incluindo a física e a engenharia. Recentemente, foram feitas novas investigações sobre a lógica de gradientes no contexto das Redes Neurais Informadas por Física (PINNs).

Arquitetura de modelo

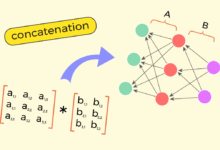

As PINNs diferem das redes neurais convencionais, pois precisam de uma lógica de gradiente distinta que considere as leis da física. A estrutura das PINNs é projetada para respeitar os princípios físicos enquanto ainda permite a personalização das funções jurídicas. A utilização de tensores e suas propriedades, como requires_grad e is_leaf, desempenha um papel fundamental na construção do modelo.

“É uma exploração do lado bizarro do autograd, onde os gradientes servem à física, não apenas a pesos.”

(“It’s a tour through the bizarre side of autograd — where gradients serve physics, not just weights.”)— Autor, Pesquisador

A definição de um tensor na computação é um array multidimensional, que em contextos como o PyTorch é utilizado para representar dados e parâmetros do modelo. Neste ambiente, o comportamento dos tensores, especialmente os leaf tensors, é essencial no processo de retropropagação e na retenção de gradientes.

Treinamento e otimização

A otimização de uma PINN requer atenção especial na retenção de gradientes. Durante o treinamento, é crítico saber como armazenar e acessar as informações relacionadas aos gradientes, especialmente em tensores intermediários. Por padrão, apenas leaf tensors mantêm seus gradientes, exigindo uma intervenção adicional quando os gradientes de outros tensores forem necessários.

“A maioria dos tutoriais sobre gradientes do PyTorch foca na retropropagação em aprendizado supervisionado.”

(“Most tutorials about PyTorch gradients focus on backpropagation in classical supervised learning.”)— Autor, Pesquisador

O uso de funções como retain_grad() permite que os usuários ajustem a continuidade dos gradientes em tensores não-leaf, o que é crucial para manter uma compreensão clara sobre os dados gerados durante as iterações de treinamento.

Resultados e métricas

Métricas de desempenho e precisão no treino de PINNs foram avaliadas, destacando o impacto significativo de configurações como create_graph para que os gradientes possam ser tratados como tensores não-leaf. Essa funcionalidade permite a computação de derivadas de ordem superior, essencial em muitos modelos complexos.

O exemplo prático envolve calcular derivadas de segundo grau, uma característica chave para o desenvolvimento de modelos que combinam aprendizado de máquina e teorias físicas. Essa abordagem permite não só resultados mais amplos como também a possibilidade de inovações futuras.

“Veremos como o create_graph transforma gradientes em cidadãos diferenciáveis do mundo autograd.”

(“We will see how create_graph turns gradients into differentiable citizens of the autograd world.”)— Autor, Pesquisador

As pesquisas em curso estão mirando na eficiência computacional e na capacidade de fazer inferências em tempo real, o que poderá transformar aplicações práticas, desde simulações físicas até previsão em tempo real.

Fonte: (Towards Data Science – AI, ML & Deep Learning)