São Paulo — InkDesign News — Um novo estudo investiga como a qualidade das interações humanas com machine learning impacta resultados de modelos de inteligência artificial. O foco está em como a formação de perguntas pode influenciar as respostas obtidas.

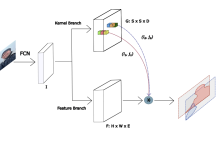

Arquitetura de modelo

A estrutura de um modelo de aprendizado profundo, como as redes neurais, é fundamental para o desempenho geral. Pesquisadores têm explorado a importância de uma arquitetura balanceada para garantir respostas mais precisas e menos enviesadas. A linguagem utilizada nas solicitações, por exemplo, pode direcionar a rede para dar mais importância a determinados aspectos das respostas.

“A forma como você fala com a IA pode orientar suas respostas de maneira que não beneficia a qualidade das respostas.”

(“The way you talk to AI may steer it in a certain direction that does not benefit the quality of your answers.”)— Daphne, DAPPER works

Treinamento e otimização

O treinamento de modelos é um processo decisivo, onde dados de entrada e metodologias de otimização afetam diretamente os resultados. Modelos com dados enviesados, como aqueles que apresentam viés demográfico ou cultural, produzem respostas que podem reforçar estereótipos ou falhas de entendimento. O uso de metodologias adequadas no treinamento e ferramentas como transfer learning pode minimizar essas distorções.

“O viés pode criar respostas menos nuançadas ou até incorretas.”

(“Bias can reduce that quality.”)— Daphne, DAPPER works

Resultados e métricas

Ao implementar abordagens para mitigar o viés, métricas de desempenho, como a acurácia e o tempo de treinamento, são avaliadas. Estudos mostram que pequenas alterações na formulação das perguntas resultam em diferenças significativas nas respostas. É possível, por exemplo, aumentar a diversidade de exemplos nos prompts para garantir que o modelo reflita uma gama mais ampla de perspectivas.

“Com prompts de poucos exemplos, o risco de viés é mais visível.”

(“The risk of bias exists whenever you give an AI model a prompt.”)— Daphne, DAPPER works

Como passo futuro, a pesquisa deverá se concentrar em como as interações contínuas com os modelos de IA podem ser otimizadas para garantir resultados mais precisos e justos. A construção de um entendimento mais robusto das aplicações práticas em áreas como política e pesquisa pode trazer benefícios significativos.

Fonte: (Towards Data Science – AI, ML & Deep Learning)