São Paulo — InkDesign News —

Uma nova técnica desenvolvida por pesquisadores australianos pode bloquear sistemas de inteligência artificial (IA) não autorizados de aprender com fotos, obras de arte e outros conteúdos baseados em imagem.

Contexto da pesquisa

O método foi criado pela CSIRO, a agência nacional de ciência da Austrália, em parceria com o Centro de Pesquisa Cooperativa em Cibersegurança (CSCRC) e a Universidade de Chicago. O objetivo é proteger artistas, organizações e usuários de redes sociais do uso não autorizado de seu conteúdo para treinar sistemas de IA ou criar deepfakes.

Método proposto

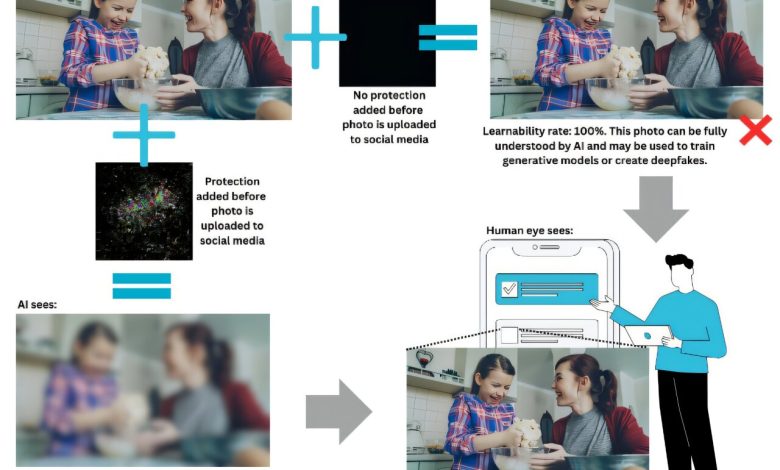

A abordagem inovadora altera sutilmente o conteúdo de forma a torná-lo ilegível para modelos de IA, mas ainda reconhecível para o olho humano. Esse método estabelece um limite sobre o que um sistema de IA pode aprender a partir do conteúdo protegido e oferece uma garantia matemática de que essa proteção se mantém estável, mesmo diante de ataques adaptativos ou tentativas de re-treinamento.

“A nossa abordagem é diferente; podemos garantir matematicamente que modelos de aprendizado de máquina não autorizados não podem aprender a partir do conteúdo além de um determinado limite. Isso é uma salvaguarda poderosa para usuários de redes sociais, criadores de conteúdo e organizações.”

(“Our approach is different; we can mathematically guarantee that unauthorized machine learning models can’t learn from the content beyond a certain threshold. That’s a powerful safeguard for social media users, content creators, and organizations.”)— Dr. Derui Wang, Cientista, CSIRO

Resultados e impacto

Embora o método atualmente se aplique apenas a imagens, há planos para expandi-lo para texto, música e vídeos. Os resultados foram validados em um ambiente controlado de laboratório, e o código foi disponibilizado no GitHub para uso acadêmico.

A técnica pode ser aplicada automaticamente em larga escala, permitindo que plataformas de redes sociais ou sites incorporem essa camada protetora em cada imagem carregada. Essa inovação pode reduzir a proliferação de deepfakes e o roubo de propriedade intelectual.

O artigo intitulado “Provably Unlearnable Data Examples” foi apresentado no Simpósio de Segurança de Sistemas e Redes Distribuídas (NDSS 2025), onde recebeu o prêmio de artigo distinto.

Essa abordagem abre novas possibilidades para a proteção do conteúdo online e poderá ter um impacto significativo na forma como dados são utilizados por sistemas de IA no futuro.

Fonte: (TechXplore – Machine Learning & AI)