São Paulo — InkDesign News —

Pesquisadores da Universidade Johns Hopkins desenvolveram um método inovador em machine learning, permitindo que modelos de inteligência artificial possam admitir incertezas ao responder perguntas, melhorando a precisão e segurança em aplicações críticas.

Contexto da pesquisa

A incapacidade de sistemas de IA de reconhecer sua própria incerteza pode levar a respostas incorretas, especialmente em áreas de alto risco como saúde, direito e engenharia. Esse desafio motivou uma equipe de cientistas da computação da Johns Hopkins a investigar como períodos de reflexão mais longos poderiam ajudar modelos a determinar a certeza de suas respostas.

Método proposto

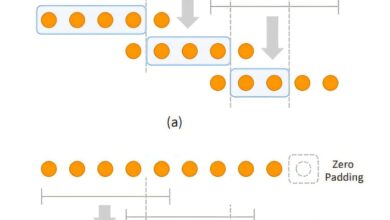

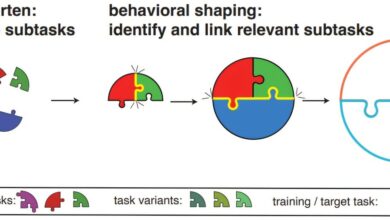

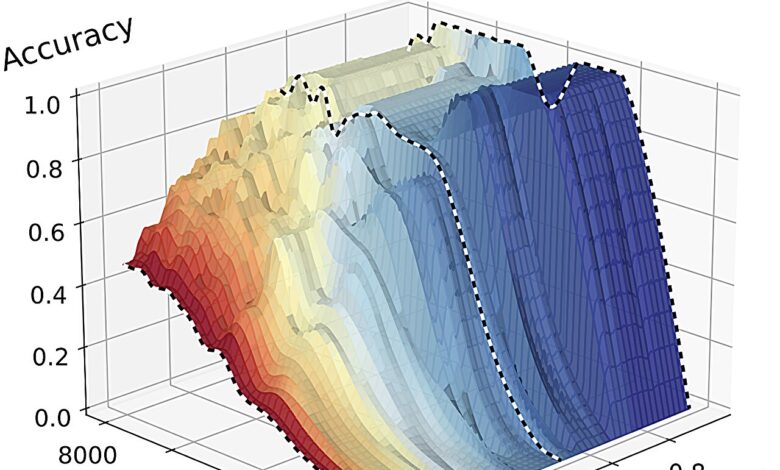

O estudo focou em modelos de linguagem de larga escala, onde a equipe analisou a relação entre os comprimentos das cadeias de raciocínio geradas e a precisão das respostas em problemas matemáticos complicados. Os modelos foram programados para responder apenas quando sua confiança ultrapassasse um limite estipulado, permitindo respostas como “não sei” quando a incerteza era alta.

“Tudo começou quando percebemos que modelos de linguagem de ponta gastam mais tempo pensando para resolver problemas mais difíceis. Então nos perguntamos: esse tempo adicional pode ajudar esses modelos a determinar se um problema foi solucionado corretamente?”

(“It all started when we saw that cutting-edge large language models spend more time thinking to solve harder problems. So we wondered—can this additional thinking time also help these models determine whether or not a problem has been solved correctly?”)— William Jurayj, Ph.D. Student, Johns Hopkins University

Resultados e impacto

Os pesquisadores descobriram que um maior tempo de reflexão geralmente melhora a precisão e a confiança dos modelos. Porém, constatou-se que sem penalidades para respostas incorretas, a precisão poderia diminuir se os modelos fossem obrigados a ter uma alta confiança. Os pesquisadores propuseram três “configurações de apostas” para penalizar erros: sem penalização, penalizações equilibradas e penalizações severas em respostas erradas.

Com configurações mais estritas, a equipe concluiu que os modelos deveriam recusar responder se a confiança não fosse adequada, o que, em ambientes críticos, pode ser preferível a fornecer uma resposta errada após um longo tempo de espera.

“Um estudante pode ficar ligeiramente irritado em esperar 10 minutos apenas para descobrir que precisa resolver um problema de matemática. Mas em ambientes críticos, isso é infinitamente preferível a esperar cinco minutos por um resposta que parece correta, mas não é.”

(“A student might be mildly annoyed to wait 10 minutes only to find out that she needs to solve a math problem herself because the AI model is unsure. But in high-stakes environments, this is infinitely preferable to waiting five minutes for an answer that looks correct but is not.”)— William Jurayj, Ph.D. Student, Johns Hopkins University

Os pesquisadores estão agora incentivando a comunidade de IA a divulgar o desempenho de seus modelos em cenários que envolvem custos reais para respostas erradas, promovendo assim desenvolvimentos em quantificação de incerteza.

Fonte: TechXplore – Machine Learning & AI