São Paulo — InkDesign News —

A pesquisa em machine learning e inteligência artificial tem sido constantemente desafiada por novas descobertas, particularmente na área de marcação semântica de imagens, onde recentementes pesquisadores da Ruhr University Bochum identificaram vulnerabilidades críticas.

Contexto da pesquisa

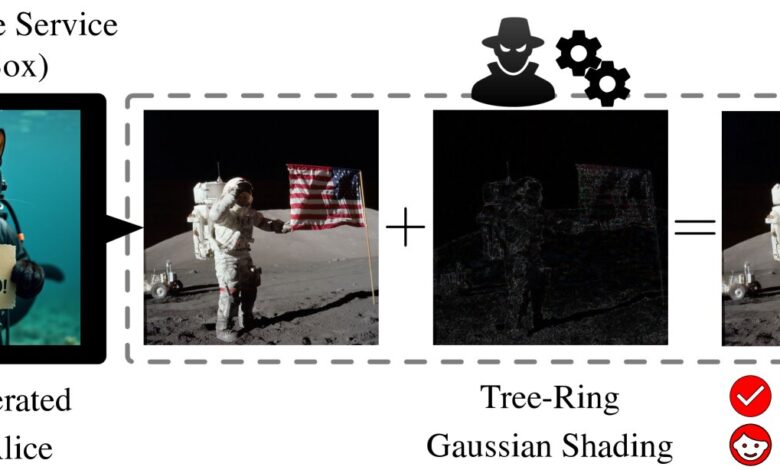

As marcas d’água, visíveis ou invisíveis, inseridas em arquivos de imagem, são fundamentais para verificar a origem de conteúdos gerados por AI. Com as chamadas marcas d’água semânticas, que são inseridas profundamente no processo de geração de imagens, acredita-se que sejam robustas e difíceis de remover. No entanto, uma equipe de pesquisadores apresentou novos métodos que comprometem esta premissa.

Método proposto

A apresentação foi feita durante a Conferência sobre Visão Computacional e Reconhecimento de Padrões (CVPR 2025) em Nashville, Tennessee, onde a equipe descreveu duas novas estratégias de ataque. O primeiro método, conhecido como ataque de impressão, modifica a representação latente de uma imagem real para que se assemelhe à de uma imagem que contém uma marca d’água.

“Demonstramos que atacantes poderiam forjar ou remover completamente marcas d’água semânticas usando métodos surpreendentemente simples”

(“We demonstrated that attackers could forge or entirely remove semantic watermarks using surprisingly simple methods.”)— Andreas Müller, Professor, Ruhr University Bochum

O segundo método, o ataque de reprompting, explora a capacidade de retornar uma imagem marcada para o espaço latente e depois regenerá-la com um novo prompt, resultando em imagens que carregam a mesma marca d’água.

Resultados e impacto

Ambos os ataques podem ser realizados com apenas uma imagem de referência e funcionam em diferentes arquiteturas de modelo, incluindo sistemas baseados em UNet e transformadores de difusão. Essa flexibilidade apresenta uma preocupação significativa para a segurança da avaliação de imagens geradas por AI. Os pesquisadores argumentam que atualmente não existem defesas eficazes contra esses tipos de ataques.

“Isso coloca em questão como podemos rotular e autenticar com segurança o conteúdo gerado por AI no futuro”

(“This calls into question how we can securely label and authenticate AI-generated content moving forward.”)— Andreas Müller, Professor, Ruhr University Bochum

O impacto desta pesquisa é profundo, pois a abordagem atual de marcação semântica precisa ser repensada para garantir a confiança e a resiliência a longo prazo na atribuição de conteúdo gerado por máquinas. A continuidade das investigações poderá levar a novas metodologias que reforcem a credibilidade nas marcas d’água semânticas e nas suas aplicações práticas.

Fonte: (TechXplore – Machine Learning & AI)