São Paulo — InkDesign News — A crescente complexidade em aplicações de machine learning, especialmente em altas dimensões, tem desafiado algoritmos tradicionais como o Kernel Density Estimation (KDE). Um novo estudo apresenta o Masked Autoregressive Flow (MAF) como uma alternativa promissora.

Arquitetura de modelo

No contexto do aprendizado de máquina, o KDE é amplamente utilizado para estimar densidades em dados de baixa dimensão. Entretanto, como apontado na pesquisa, “um dos principais problemas que surge na estimativa de densidade em alta dimensão é que, à medida que a dimensão aumenta, nossos dados se tornam mais escassos.” (“One of the main problems that arises in high-dimensional density estimation is that as our dimension increases, our data becomes more sparse.”)

Um dos principais problemas que surge na estimativa de densidade em alta dimensão é que, à medida que a dimensão aumenta, nossos dados se tornam mais escassos.

(“One of the main problems that arises in high-dimensional density estimation is that as our dimension increases, our data becomes more sparse.”)— Autor Desconhecido, Estudo de Flows

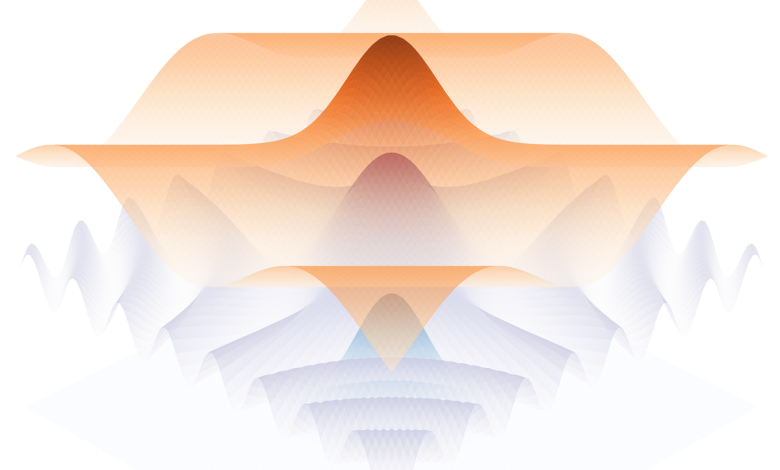

Por outro lado, os Normalizing Flows, particularmente o MAF, transformam variáveis aleatórias de uma distribuição simples em distribuições mais complexas através de transformações diferenciáveis e invertíveis, melhorando a captação de padrões em dados.

Treinamento e otimização

A pesquisa comparou os dois métodos em termos de eficiência de dados e tempo de treinamento. Os experimentos mostraram que, enquanto o KDE requer tempo significativo para ajustar parâmetros, o MAF demonstrou desempenho superior em dimensões mais altas. De acordo com o estudo, “a diferença de desempenho é notável após a quinta dimensão, onde o MAF começou a superar drasticamente o KDE.” (“the relative performance of KDE and MAF… a transition occurs around the fifth dimension, where MAF begins to vastly outperform KDE.”)

A diferença de desempenho é notável após a quinta dimensão, onde o MAF começou a superar drasticamente o KDE.

(“the relative performance of KDE and MAF… a transition occurs around the fifth dimension, where MAF begins to vastly outperform KDE.”)— Autor Desconhecido, Estudo de Flows

Resultados e métricas

Os resultados revelaram que o MAF, ao atingir um limite de divergência KL de 0.5, necessitou de apenas cerca de 2.000 pontos de dados, enquanto o KDE exigiu mais de 100.000. Esta melhoria na eficiência de dados foi observada em diferentes famílias de distribuições, incluindo distribuições gaussianas e normais assimétricas.

A capacidade do MAF de aprender representações gerais através de um modelo de rede neural o torna mais adequado para aplicações em dimensões elevadas. Além disso, “o MAF não utiliza estimativas baseadas em vizinhança local, permitindo uma melhor escalabilidade.” (“MAF doesn’t use local neighborhood based estimation, allowing it to scale far better than KDE with dimension.”)

O MAF não utiliza estimativas baseadas em vizinhança local, permitindo uma melhor escalabilidade.

(“MAF doesn’t use local neighborhood based estimation, allowing it to scale far better than KDE with dimension.”)— Autor Desconhecido, Estudo de Flows

Portanto, para aplicações em dados de alta dimensão, a adoção de MAF pode não apenas acelerar o treinamento, mas também melhorar a precisão da modelagem.

Essa pesquisa apresenta um pivot na forma como distribuímos a complexidade em machine learning, especialmente em campos como visão computacional, análise de dados complexos e outras áreas que demandam alta eficiência na estimativa de densidade.

Fonte: (Towards Data Science – AI, ML & Deep Learning)