Machine learning transforma gestos em fala para comunicação limitada

São Paulo — InkDesign News —

Uma nova pesquisa em machine learning e inteligência artificial está ajudando pessoas com limitações motoras e visuais a se comunicarem de maneira mais eficaz, interpretando gestos em saída de voz.

Contexto da pesquisa

Na Universidade Estadual da Pensilvânia, pesquisadores liderados pela professora Krista Wilkinson e pelo professor Syed Billah desenvolveram um protótipo que emprega sensores de movimento para traduzir gestos corporais em fala.

Método proposto

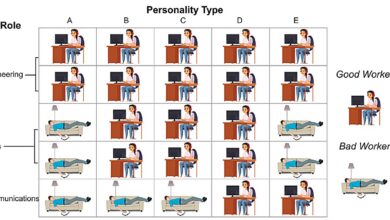

O protótipo utiliza uma abordagem baseada em machine learning, com algoritmos que reconhecem e interpretam padrões específicos de movimento. Sensores instalados em um dispositivo portable capturam a cinemática das gesticulações. O sistema aprende a distinguir entre diferentes gestos, convertendo-os em comandos que permitem a comunicação. O time focou em implementar um processo simples, onde movimentos são repetidos três vezes para minimizar a fadiga do usuário.

“A ideia é que podemos criar um pequeno dicionário dos gestos mais utilizados que têm significado comunicativo para o usuário”

(“The idea is that we can create a small dictionary of an individual’s most commonly used gestures that have communicative meaning to them.”)— Krista Wilkinson, Professora, Universidade Estadual da Pensilvânia

Resultados e impacto

Os testes iniciais incluíram três indivíduos com deficiências motoras ou visuais, e todos relataram uma melhoria significativa na capacidade de se comunicar rapidamente. O algoritmo não apenas converte gestos em fala, mas também reduz potenciais erros, adaptando-se aos padrões de movimento individuais.

Com esta tecnologia, indivíduos que utilizam AAC (Comunicação Aumentativa e Alternativa) podem interagir de forma mais independente, rompendo barreiras anteriormente impostas por gestos não compreendidos por aqueles fora de seu círculo íntimo.

Os próximos passos incluem a aplicação de algoritmos baseados em câmera para complementar os sensores, permitindo um reconhecimento ainda mais preciso dos gestos e ampliando as aplicações em diversos contextos sociais.

Fonte: (TechXplore – Machine Learning & AI)