LLMs constroem e consultam knowledge graphs em machine learning

São Paulo — InkDesign News —

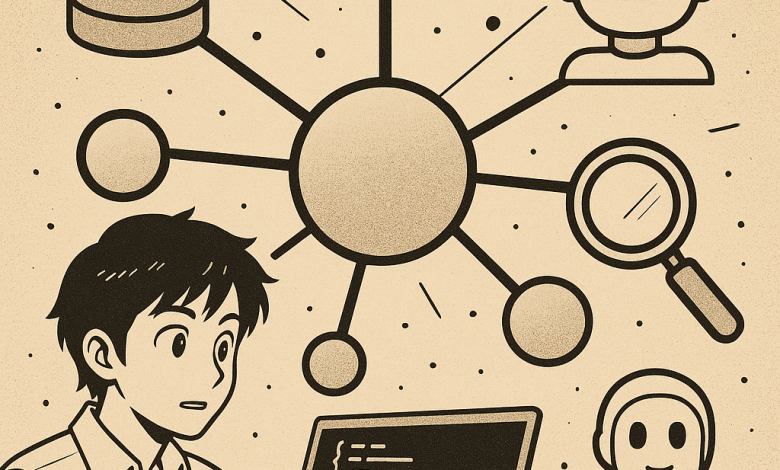

Um avanço significativo em machine learning traz novas estratégias para integrar grafos de conhecimento e grandes modelos de linguagem (LLMs), ampliando a capacidade de recuperação e geração de informações estruturadas e contextuais.

Arquitetura de modelo

O uso de Grafos de Conhecimento (Knowledge Graphs) permite representar informações de forma estruturada, conectando conceitos, entidades e relacionamentos, facilitando o raciocínio e a inferência automática. Em projetos atuais, bancos de dados como o Neo4j são híbridos, integrando vetores de embedding para buscas semânticas, além de armazenar as relações e propriedades dos dados. O framework LangChain é utilizado para coordenar as interações entre LLMs e as ferramentas de consulta, incorporando agentes customizados que aproveitam a ontologia do domínio para extrair grafos conceituais validados por modelos robustos.

“Um Ontologia pode ser descrita como a especificação formal dos tipos de entidades e relacionamentos que podem existir no grafo — é, essencialmente, sua planta baixa.”

(“An ontology can be described as the formal specification of the types of entities and relationships that can exist in the graph — it is, essentially, its blueprint.”)— Dylan Tartarini, Engenheiro de Dados, Projeto Knowledge Graphs

Tais estruturas são alimentadas por documentos de um mesmo domínio — como materiais da Comissão Europeia — processados em etapas de ingestão que incluem limpeza, chunking e embedding dos textos. A combinação entre grafos e técnicas de vetorização evidencia melhorias na organização e recuperação contextualizada dos dados.

Treinamento e otimização

O pipeline de ingestão contempla a segmentação dos documentos em chunks, a extração estruturada de conceitos via LLMs com saída validada, e a indexação híbrida que conecta esses chunks em um grafo com relações explícitas, como “PART_OF” e “MENTIONS”. Além disso, são empregadas técnicas de clusterização hierárquica (Leiden, Louvain) para formar comunidades de nós, cujos resumos são gerados por LLMs e armazenados também como embeddings.

“O uso de busca híbrida combinando embeddings e filtros semânticos enriquecidos com vizinhança no grafo pode desbloquear novas possibilidades para fornecer respostas detalhadas e contextualizadas.”

(“Querying for similarity on embeddings and then enriching the context with neighbouring chunks might unlock new possibilities when it comes to level of details provided in the answer.”)— Dylan Tartarini, Engenheiro de Dados, Projeto Knowledge Graphs

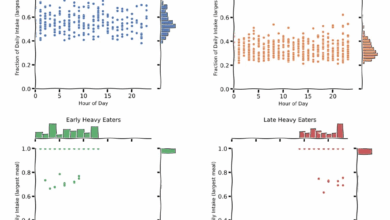

Esse modelo híbrido permite múltiplas estratégias de busca: desde a similaridade vetorial pura, passando pela consulta via linguagem Cypher para navegação no grafo, até abordagens combinadas que integram grafo e RAG (Retrieval Augmented Generation), equilibrando precisão e eficiência computacional.

Resultados e métricas

Comparativos entre essas abordagens indicam trade-offs entre uso de tokens, latência e performance na geração de respostas. A consulta por Cypher é eficiente para respostas objetivas e esquemas de grafo bem definidos, enquanto a busca aumentada pelo grafo aborda melhor questões que envolvem múltiplas fontes e contextos multi-hop. A geração de relatórios comunitários agrega um nível extra de síntese contextual, embora ainda esteja em aprimoramento devido à complexidade do contexto reunido.

“Quando se constrói aplicações reais, é crítico ponderar estratégias não apenas pela acurácia, mas também pelo custo, velocidade e escalabilidade.”

(“When building real-world applications, it’s critical to weight answering strategies not just by accuracy, but also by cost, speed, and scalability.”)— Dylan Tartarini, Engenheiro de Dados, Projeto Knowledge Graphs

Vislumbram-se avanços no desenvolvimento de sistemas inteligentes que valorizam a estruturação semântica do conhecimento, combinando grafos e LLMs para respostas mais fundamentadas e contextualizadas. A continuidade da pesquisa deve focar na otimização dessas técnicas para cenários de larga escala e diversidade documental.

Para entender mais sobre o tema e acessar código e exemplos práticos, o projeto está disponível no repositório público no GitHub do autor.

Fonte: (Towards Data Science – AI, ML & Deep Learning)