Uma nova pesquisa apresenta avanços em machine learning, utilizando modelos de linguagem para decifrar como o cérebro humano compreende cenas visuais, destacando ligações entre inteligência artificial e percepção humana.

Contexto da pesquisa

No estudo publicado na revista Nature Machine Intelligence, o professor associado de psicologia da Université de Montréal, Ian Charest, e sua equipe da Universidade de Minnesota, da Universidade de Osnabrück e da Freie Universität Berlin, exploraram a relação entre representações visuais humanas e modelos de linguagem.

Método proposto

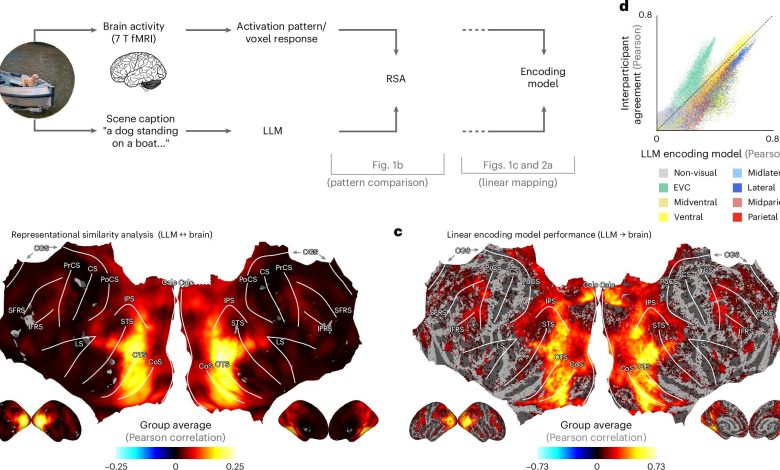

A equipe utilizou modelos de linguagem (LLMs), como os que alimentam ferramentas como o ChatGPT, para criar uma “impressão digital baseada em linguagem” das descrições das cenas naturais. “Ao alimentar descrições de cenas naturais nesses LLMs, criamos uma espécie de ‘impressão digital baseada em linguagem’ do que uma cena significa”, afirma Charest.

Resultados e impacto

Os resultados mostraram que essas impressões digitais se correlacionaram estreitamente com os padrões de atividade cerebral registrados enquanto indivíduos observavam as mesmas cenas em um escâner de ressonância magnética. “Usando LLMs, conseguimos decodificar em uma frase a cena visual que a pessoa acabou de perceber”, explica Charest. Além disso, a equipe treinou redes neurais artificiais que analisavam imagens e previam essas impressões digitais dos LLMs, encontrando uma precisão maior do que muitos dos modelos de visão artificial mais avançados disponíveis atualmente.

“O que aprendemos sugere que o cérebro humano pode representar cenas visuais complexas de uma maneira surpreendentemente semelhante a como os modelos de linguagem modernos entendem os textos.”

(“What we’ve learned suggests that the human brain may represent complex visual scenes in a way that’s surprisingly similar to how modern language models understand text.”)— Ian Charest, Professor Associado, Université de Montréal

Esses avanços têm várias implicações, incluindo a melhora de interfaces cérebro-máquina e o desenvolvimento de sistemas de IA que “veem” de maneira mais semelhante aos humanos. A pesquisa abre a possibilidade de desenvolver modelos computacionais de visão que poderiam auxiliar em decisões para veículos autônomos e, possivelmente, em próteses visuais para pessoas com deficiências significativas.

Fonte: (TechXplore – Machine Learning & AI)