Contexto da pesquisa

A aplicação de machine learning tem se mostrado promissora em diversas áreas, mas a adaptação de modelos em situações complexas ainda é um desafio. Pesquisadores do MIT exploraram uma técnica de treinamento que poderá aumentar a flexibilidade e a precisão de modelos de linguagem em tarefas inéditas e exigentes.

Método proposto

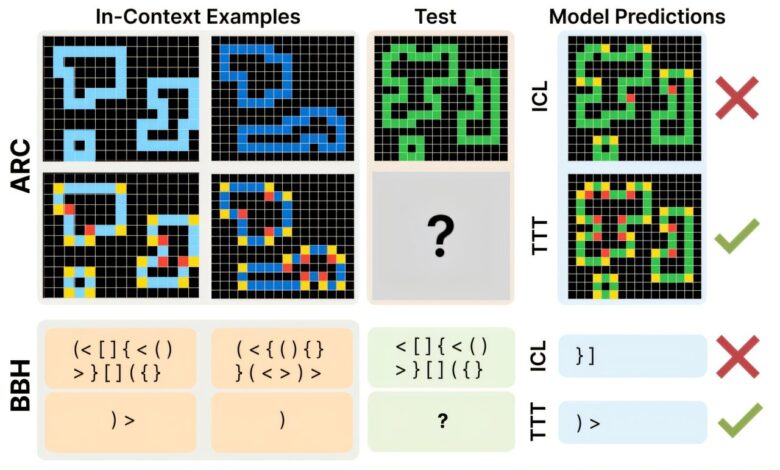

O estudo focou na otimização de modelos de linguagem de grande escala (LLMs) através de uma abordagem chamada treinamento em tempo de teste (test-time training), que envolve a atualização temporária dos parâmetros do modelo durante a execução. Essa técnica é combinada com a aprendizagem em contexto (in-context learning), onde o modelo é alimentado com exemplos específicos de uma nova tarefa.

Os pesquisadores analisaram como o treinamento em tempo de teste poderia ser implementado eficazmente. Eles usaram um conjunto de dados de tarefas complexas, como quebra-cabeças de raciocínio lógico, para demonstrar a eficácia de sua estratégia. A melhoria na precisão foi notável, com um aumento de até seis vezes em comparação a abordagens que utilizam apenas a aprendizagem em contexto.

Resultados e impacto

Os resultados mostraram que os LLMs podem se beneficiar significativamente da atualização de parâmetros em situações complicadas. Daniel Damani, um dos co-autores, afirma: “Descobrimos que o treinamento em tempo de teste é uma forma de aprendizado muito mais forte. Enquanto fornecer exemplos pode aumentar modestamente a precisão, realmente atualizar o modelo com esses exemplos pode levar a um desempenho significativamente melhor, especialmente em domínios desafiadores.”

Utilizando técnicas como adaptação de baixa ordem, os pesquisadores conseguiram realizar as atualizações de maneira eficiente, o que é crucial para a aplicação em cenários do mundo real.

Os testes foram feitos em dois conjuntos de dados de problemas complexos, mostrando a eficácia da abordagem. A unidade que normalmente levaria menos de um minuto para oferecer uma resposta pode, em algumas situações, levar de cinco a dez minutos com o treinamento em tempo de teste, mas a precisão alcançada justifica esse tempo extra.

“Para tarefas mais simples, a aprendizagem em contexto pode ser suficiente. Mas atualizar os próprios parâmetros pode desenvolver uma nova habilidade no modelo,” disse Damani.

— Daniel Damani, Pesquisador, MIT

As implicações dessa pesquisa são vastas, potencialmente transformando áreas que vão desde diagnósticos médicos até gestão de cadeias de suprimento. Os pesquisadores esperam desenvolver modelos que consigam decidir automaticamente entre a utilização de treinamento em tempo de teste ou aprendizagem em contexto para resolver tarefas de forma mais eficiente no futuro.

Fonte: (TechXplore – Machine Learning & AI)