São Paulo — InkDesign News —

Pesquisadores desenvolveram uma técnica que aprimora significativamente o desempenho de modelos de linguagem de grande porte, utilizando machine learning, sem aumentar o poder computacional necessário para o ajuste fino desses modelos.

Contexto da pesquisa

Os modelos de linguagem de grande porte (LLMs) são sistemas de inteligência artificial que são pré-treinados em vastos conjuntos de dados. Após essa fase, eles prevêem quais palavras devem seguir umas às outras, a fim de responder a consultas dos usuários. A natureza não específica do pré-treinamento deixa espaço para melhorias consideráveis quando as consultas são focadas em tópicos específicos, como questões matemáticas ou geração de código.

Método proposto

O coautor da pesquisa, Tianfu Wu, professor associado de engenharia computacional na North Carolina State University, afirmou:

“Para melhorar a capacidade de um modelo em realizar tarefas específicas, é necessário ajustar o modelo.”

(“In order to improve a model’s ability to perform more specific tasks, you need to fine-tune the model.”)— Tianfu Wu, Professor Associado, North Carolina State University

O método proposto, denominado WeGeFT (Weight-Generative Fine-Tuning), se baseia em uma técnica anterior chamada LoRA, que utiliza ferramentas matemáticas para identificar um subconjunto pequeno de parâmetros-chave que têm maior probabilidade de melhorar o desempenho do modelo para uma tarefa específica.

Resultados e impacto

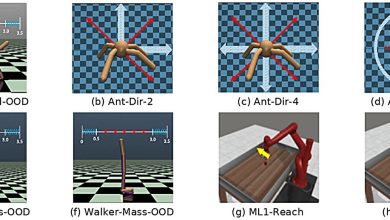

Em testes de prova de conceito, o WeGeFT demonstrou desempenho equivalente ou superior ao LoRA e suas variantes em diversas tarefas, incluindo raciocínio baseado em senso comum, raciocínio aritmético, seguimento de instruções, geração de código e reconhecimento visual.

Como afirmado por Wu,

“Acreditamos que este é um passo valioso.”

(“We think this is a valuable step forward.”)— Tianfu Wu, Professor Associado, North Carolina State University

O trabalho está alinhado com a exploração de como o WeGeFT pode ser utilizado para identificar elementos do modelo responsáveis por saídas prejudiciais, visando melhorar a segurança e a conformidade da IA. Essas investigações estão agendadas para progressão nas próximas fases.

Fonte: (TechXplore – Machine Learning & AI)