São Paulo — InkDesign News — Em um mundo movido por avanços em machine learning e deep learning, a evolução dos modelos de linguagem destaca-se como um marco na comunicação homem-máquina, culminando em tecnologias como o ChatGPT.

Arquitetura de modelo

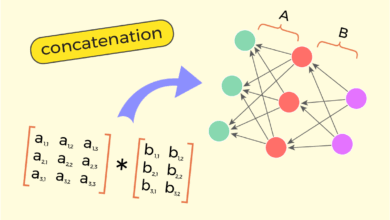

O modelo Transformer, introduzido no artigo “Attention is All You Need” em 2017, revolucionou a arquitetura de redes neurais ao eliminar recursão em favor de uma abordagem baseada apenas em atenção, facilitando a escalabilidade. Essa mudança permitiu um avanço significativo em tarefas como tradução de linguagens. A ideia central do Transformer reside em “…o que realmente é interessante é que se você considerar o delta entre os elementos arquitetônicos no estado anterior da arte e o próprio Transformer, nada novo foi adicionado. Em vez disso, um elemento específico (recorrência) foi subtraído”. (“What’s really interesting is that if you consider the delta between the architectural elements in the previous state of the art before the Transformer and the Transformer itself, nothing new was added. Instead, a specific element (recurrence) was subtracted.”)

“…o que realmente é interessante é que se você considerar a diferença entre os elementos arquitetônicos no estado anterior da arte e o Transformer, nada novo foi adicionado. Em vez disso, um elemento específico (recorrência) foi subtraído.”

(“What’s really interesting is that if you consider the delta between the architectural elements in the previous state of the art before the Transformer and the Transformer itself, nothing new was added. Instead, a specific element (recurrence) was subtracted.”)— Autor Desconhecido

A transição do foco da tradução de idiomas para capacidades mais amplas de linguagem destaca a adaptabilidade do modelo. O primeiro modelo GPT (Generative Pre-Trained Transformer), lançado em 2018, demonstrou o potencial de usar uma única arquitetura para múltiplas tarefas de linguagem, servindo como base para desenvolvimentos futuros.

Treinamento e otimização

O treinamento do GPT-3, lançado em 2020, com 175 bilhões de parâmetros, foi uma etapa crucial. Os pesquisadores exploraram a capacidade do modelo de aprender tarefas novas com apenas alguns exemplos. A eficiência em lidar com zero-shot, one-shot e few-shot learning foram notáveis. “A capacidade dos modelos de linguagem aumentou substancialmente, de 100 milhões de parâmetros para 175 bilhões, trazendo melhorias nas tarefas de processamento de linguagem natural” (“In recent years the capacity of transformer language models has increased substantially, from 100 million parameters to 175 billion, bringing improvements in downstream natural language processing tasks”).

“A capacidade dos modelos de linguagem aumentou substancialmente, de 100 milhões de parâmetros para 175 bilhões, trazendo melhorias nas tarefas de processamento de linguagem natural.”

(“In recent years the capacity of transformer language models has increased substantially, from 100 million parameters to 175 billion, bringing improvements in downstream natural language processing tasks.”)— Autor Desconhecido

Os resultados mostraram que a inclusão de exemplos contextuais durante a inferência aumentou significativamente a precisão nas tarefas. Trabalhos anteriores nas arquiteturas baseadas em atenção comprovam que a simplificação em relação a modelos anteriores, que dependiam de estruturas recorrentes, facilitou a escalabilidade e a rapidez do treinamento.

Resultados e métricas

Os modelos evoluíram para executar operações aritméticas básicas com alta precisão, refletindo a capacidade do GPT-3 de lidar com problemas complexos de forma mais eficiente. O desempenho em adições de dois dígitos mostrou uma taxa de precisão de 100%, levando os pesquisadores a especularem sobre a capacidade real do modelo de generalizar conhecimento.

Ainda que os modelos tivessem limitações iniciais em respeitar o contexto atualizado da informação, inovações vindouras, como o uso de APIs para acesso a dados em tempo real, prometem expandir ainda mais suas capacidades.

O caminho à frente implica uma integração contínua de modelos com foco em interação com ferramentas especializadas, como calculadoras e APIs informativas, tornando-os ainda mais versáteis em aplicações práticas.

Fonte: (Towards Data Science – AI, ML & Deep Learning)