Uma nova pesquisa destaca uma vulnerabilidade crítica em unidades de processamento gráfico (GPUs) que pode afetar modelos de machine learning (ML), colocando em risco aplicações em setores como saúde e finanças.

Contexto da pesquisa

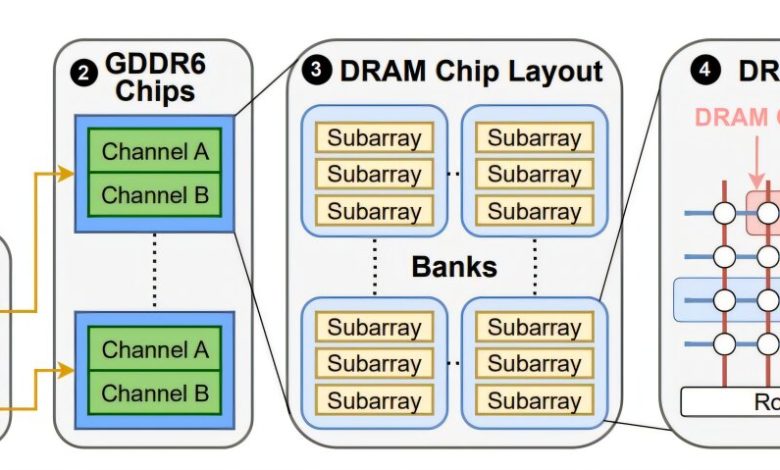

A equipe de cientistas da computação da Universidade de Toronto descobriu que um tipo de ataque de hardware conhecido como Rowhammer é eficaz contra GPUs com memória GDDR6, comumente utilizada em serviços de aprendizado de máquina.

(“A equipe de cientistas da computação da Universidade de Toronto descobriu que um tipo de ataque de hardware conhecido como Rowhammer é eficaz contra GPUs com memória GDDR6, comumente utilizada em serviços de aprendizado de máquina.”)

Método proposto

O ataque, denominado GPUHammer, explora a manipulação de células de memória, levando-as a inverter bits por acesso repetido a linhas adjacentes. Isso resulta em interferência elétrica e pode comprometer a integridade dos dados.

(“O ataque, denominado GPUHammer, explora a manipulação de células de memória, levando-as a inverter bits por acesso repetido a linhas adjacentes. Isso resulta em interferência elétrica e pode comprometer a integridade dos dados.”)

Os pesquisadores testaram a vulnerabilidade em uma NVIDIA RTX A6000, observando que uma única alteração em um bit da rede neural pode reduzir drasticamente a precisão do modelo, de 80% para apenas 0,1%.

Resultados e impacto

Os achados têm graves implicações para aplicações que dependem da precisão do machine learning, como diagnósticos médicos e sistemas antifraude.

(“Os achados têm graves implicações para aplicações que dependem da precisão do machine learning, como diagnósticos médicos e sistemas antifraude.”)

“Tradicionalmente, a segurança foi considerada apenas no nível do software, mas estamos vendo efeitos físicos no nível do hardware que podem ser explorados como vulnerabilidades.”

(“Traditionally, security has been thought of at the software layer, but we’re increasingly seeing physical effects at the hardware layer that can be leveraged as vulnerabilities.”)— Gururaj Saileshwar, Professor Assistente, Universidade de Toronto

A pesquisa mostra que, embora a correção de erros (ECC) possa mitigar os ataques, isso pode impactar o desempenho das tarefas de ML em até 10%. Além disso, novas variantes de ataques podem contornar essas proteções no futuro. A necessidade de explorar e abordar vulnerabilidades em GPUs é crítica, dado o valor das cargas de trabalho que operam nesse ambiente.

O próximo passo para a pesquisa é aprofundar ainda mais a segurança das GPUs, o que é vital para garantir a integridade de modelos que são utilizados em setores sensíveis.

(“O próximo passo para a pesquisa é aprofundar ainda mais a segurança das GPUs, o que é vital para garantir a integridade de modelos que são utilizados em setores sensíveis.”)

Fonte: (TechXplore – Machine Learning & AI)