São Paulo — InkDesign News —

Um artigo detalha como o fine-tuning em modelos de linguagem visual (VLMs) aprimora a extração de texto manuscrito, usando Qwen 2.5 VL. A técnica demonstra avanços em machine learning, superando OCR tradicional com maior acurácia e eficiência.

Arquitetura de modelo

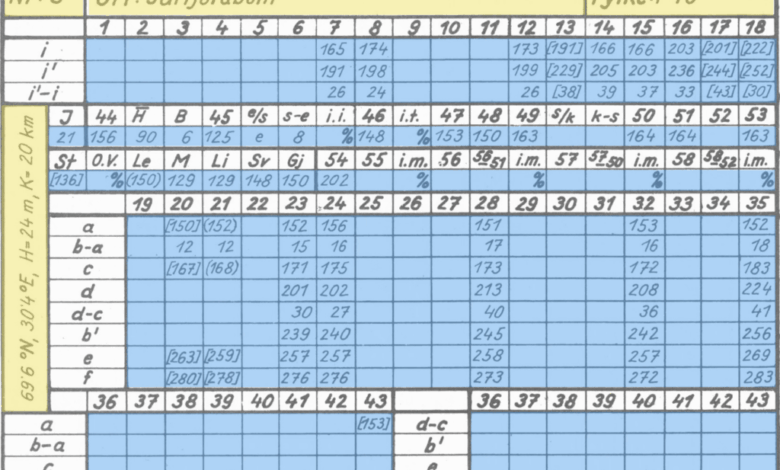

O estudo utiliza o Qwen 2.5 VL 7B, um modelo grande de linguagem visual que processa imagens por meio de transformadores visuais (ViT) e adaptadores VL, integrando tokens visuais com texto em um espaço embutido comum. Essa arquitetura permite maior sensibilidade ao contexto e instruções específicas, o que melhora a leitura de texto manuscrito não padronizado.

“VLMs superam frequentemente os mecanismos tradicionais de OCR na extração de texto de imagens.”

(“VLMs often outperform traditional OCR engines when extracting text from images.”)— Eivind Kjosbakken, Data Scientist, Findable

Treinamento e otimização

O processo de fine-tuning supervisionado (SFT) envolveu anotação iterativa em três passos: predição com o modelo base, revisão e correção das falhas, seguida por re-treinamento. Essa abordagem é eficiente quando o modelo inicial apresenta alta acurácia (90–95%). Para garantir ganhos precisos e evitar superajustes, foram aplicadas práticas como taxa de aprendizado baixa, rank LoRA reduzido, balanceamento de dados e ajuste em todas as camadas.

“A corretude dos rótulos é crucial; erros em apenas 0,5% dos dados prejudicam significativamente o desempenho.”

(“Label correctness is of utmost importance. Just a few labeling errors can have a detrimental effect on model performance.”)— Lars Aurdal, Data Scientist, Findable

O modelo recebeu instruções específicas para distinguir caracteres críticos, como “1” e “7”, com base em traços horizontais presentes no “7”. Essa diferenciação guiada, impossível em OCR tradicionais, é um diferencial dos VLMs.

Resultados e métricas

A avaliação do fine-tuning foi realizada em quatro conjuntos de teste com 278 amostras cada. O Qwen fine-tuned superou consistentemente o modelo base, mostrando melhora significativa na acurácia (até 99%) frente ao EasyOCR, que apresentou falhas severas. O treinamento, realizado em GPUs A100 80GB, durou entre 10 a 20 minutos por ciclo, possibilitando busca extensiva por hiperparâmetros.

“O esforço para melhorar a acurácia de 95% para 99% é exponencialmente maior do que o necessário para alcançar entre 80% e 90%.”

(“Much less effort is required to go from 80–90% accuracy than the effort required to go from 95–99% accuracy.”)— Eivind Kjosbakken, Data Scientist, Findable

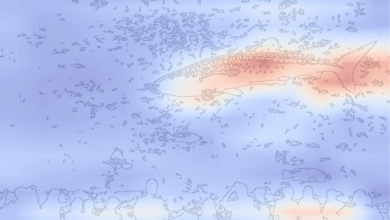

Além disso, os dados extraídos foram visualizados geograficamente no mapa da Noruega utilizando a ferramenta H3 da Uber, evidenciando padrões climáticos relacionados à vegetação.

O avanço no fine-tuning de VLMs abre perspectivas para aplicação em outras áreas que demandam leitura de texto manuscrito, como análises científicas e ambientais. Futuras pesquisas podem explorar adaptação em datasets variados e otimização de hiperparâmetros para acelerar o processo em modelos maiores.

Fonte: (Towards Data Science – AI, ML & Deep Learning)