São Paulo — InkDesign News — Uma nova pesquisa aborda as implicações do uso de técnicas de machine learning em ferramentas de proteção de arte, revelando a vulnerabilidade de modelos populares que visam proteger os direitos dos artistas digitais.

Contexto da pesquisa

Um grupo de pesquisadores internacionais, incluindo especialistas da Universidade de Cambridge, identificou fraquezas significativas nas ferramentas Glaze e NightShade, amplamente utilizadas por artistas para evitar que seus estilos sejam copiados por modelos de AI sem consentimento. Essas ferramentas somam quase 9 milhões de downloads, mas a pesquisa revelou que elas não são eficazes para proteger adequadamente o trabalho dos criadores.

Método proposto

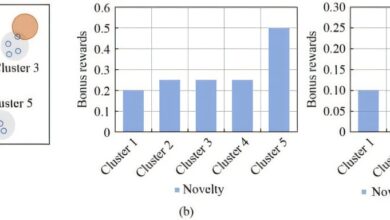

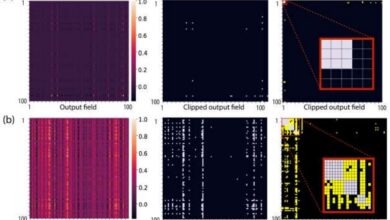

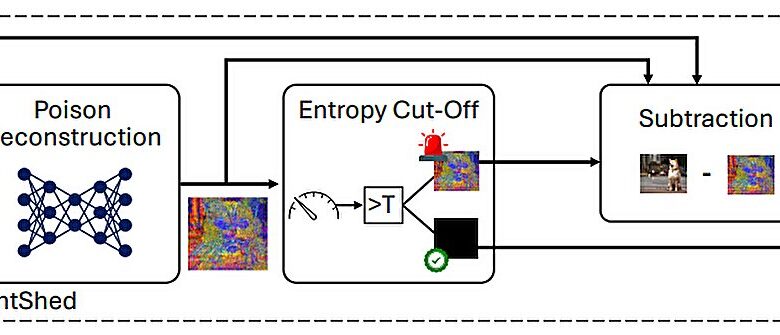

A equipe apresentou uma nova abordagem chamada LightShed, que funciona em três etapas. Primeiro, identifica se uma imagem foi alterada utilizando técnicas conhecidas de “poisoning”. Em seguida, um processo de engenharia reversa permite que o modelo aprenda as características das distorções, usando exemplos de imagens previamente adulteradas disponíveis publicamente. Finalmente, o método remove as perturbações, restaurando a imagem ao seu estado original.

Resultados e impacto

Em avaliações experimentais, o LightShed detectou imagens protegidas por NightShade com uma acurácia de 99,98% e conseguiu remover as proteções incorporadas. “Isso mostra que mesmo utilizando ferramentas como NightShade, os artistas ainda estão em risco de ter seu trabalho utilizado para treinar modelos de AI sem seu consentimento”, disse Hanna Foerster, co-autora do estudo.

“Nós vemos isso como uma oportunidade para co-evoluir defesas.”

(“We see this as a chance to co-evolve defenses.”)— Ahmad-Reza Sadeghi, Professor, Universidade Técnica de Darmstadt

A pesquisa enfatiza a necessidade urgente de desenvolver melhores estratégias de proteção voltadas para os artistas. À medida que o cenário de AI e criatividade digital evolui, as implicações legais e éticas do uso de arte no treinamento de modelos de AI continuam sendo debatidas, como demonstrado em casos recentes que envolvem grandes empresas de mídia.

Possíveis aplicações futuras incluem a colaboração com cientistas e a comunidade artística para aprimorar ferramentas de proteção que sejam mais adaptativas e resistam a adversários avançados.

Fonte: (TechXplore – Machine Learning & AI)