São Paulo — InkDesign News —

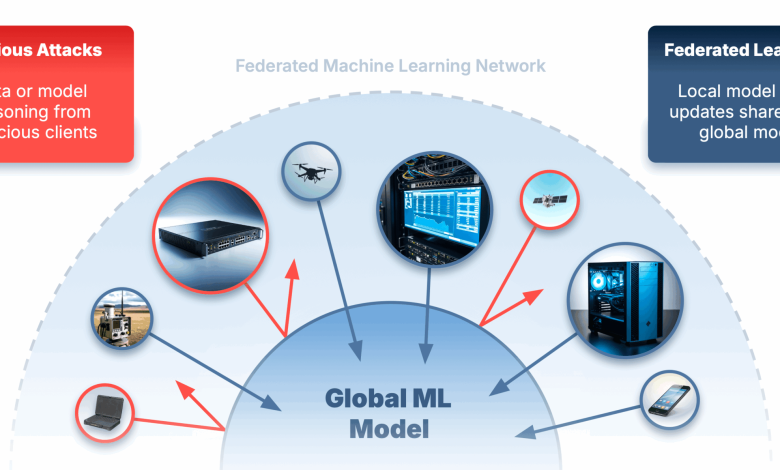

A crescente implementação de machine learning em cenários de aprendizado federado traz à tona questões críticas de segurança. Um novo estudo investiga como detectar e mitigar ataques que comprometem a integridade dos modelos.

Arquitetura de modelo

A abordagem do Federated Learning (FL) visa treinar modelos de IA mantendo os dados sensíveis em seus locais originais. Em vez de enviar informações para um servidor central, apenas atualizações de modelos são compartilhadas, preservando a privacidade.

O estudo destaca que, embora essa arquitetura ofereça vantagens significativas, novos desafios de segurança surgem. A manipulação por atacantes pode levar a degradações de precisão, outputs tendenciosos ou backdoors ocultos nos modelos.

“Um chef desonesto pode inserir ingredientes errados para sabotar um prato ou adicionar um sabor especial que apenas ele sabe como corrigir. Se ninguém verificar as receitas, todos os clientes certamente sofrerão as consequências.”

(“A dishonest chef could deliberately add the wrong ingredients to sabotage the dish, or quietly insert a special flavour that only they know how to fix. If no one checks the recipes carefully, all future diners across all restaurants could end up with ruined or manipulated meals.”)— Pesquisador, Scaleout Systems

Treinamento e otimização

Com o objetivo de avaliar a resiliência do FL contra ameaças reais, foi construído um simulador de ataque multi-nó baseado na estrutura FEDn. Este simulador permite a reprodução de ataques e a testagem de defesas, facilitando experimentos com centenas ou até milhares de clientes.

O simulador possui funcionalidades como *distribuição flexível*, *configurações de dados realistas*, injeção de ataques e *benchmarking de defesas* através de estratégias de agregação como FedAvg, Trimmed Mean e Multi KRUM.

Resultados e métricas

O estudo foi realizado em 180 experimentos, avaliando diferentes estratégias de agregação sob variados tipos de ataques e proporções de clientes maliciosos. O algoritmo EE-TrMean foi desenvolvido como uma abordagem adaptativa, permitindo uma resiliência maior em cenários de alta heterogeneidade de dados e atividades maliciosas.

Resultados revelam que, ao utilizar o EE-TrMean, o modelo manteve a precisão em 80%, minimizando as contribuições de clientes maliciosos ao longo do treinamento.

“Esta simples, mas poderosa modificação, melhora as contribuições dos clientes. A literatura aponta que, enquanto a maioria dos clientes for honesta, a precisão do modelo se mantém confiável.”

(“This simple yet powerful modification improves the client’s contributions. The literature reports that as long as the majority of clients are honest, the model’s accuracy remains reliable.”)— Pesquisador, Scaleout Systems

Enquanto técnicas de deep learning seguem evoluindo, o foco em estratégias de agregação robustas é vital para garantir a integridade dos modelos federados. Futuras pesquisas visam explorar novas abordagens que assegurem maior segurança e eficácia em ambientes de aprendizado federado.

Fonte: (Towards Data Science – AI, ML & Deep Learning)