São Paulo — InkDesign News —

Uma competição recente de machine learning trouxe à tona novos desafios e técnicas inovadoras no campo da ciência de dados. Um profissional de FinTech, enfrentando limitações significativas, conseguiu conquistar o segundo lugar na competição, utilizando apenas um laptop pessoal.

Arquitetura de modelo

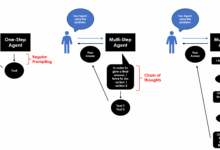

O desafio da competição era prever quais carteiras Web3 tinham maior probabilidade de inadimplência em empréstimos, utilizando dados de transações. O competidor, que possui seis anos de experiência como cientista de dados, estabeleceu uma arquitetura de rede neural com cinco camadas ocultas, cada uma contendo 64 neurônios, seguindo a configuração: ReLU para ativação e uma camada de saída sigmoide para classificação binária.

“O sucesso em aprendizado de máquina não está em ter as ferramentas mais sofisticadas ou os algoritmos mais complexos.

(“Success in machine learning isn’t about having the fanciest tools or the most complex algorithms.”)— Competidor, FinTech

Treinamento e otimização

O treinamento foi realizado sem recursos de GPU e em um período restrito de 10 horas. Técnicas como early stopping foram empregadas para evitar o overfitting, e um otimizador SGD com momentum foi escolhido para agilizar o aprendizado. O modelo demonstrou melhorias constantes no desempenho sem sinais de overfitting.

Resultados e métricas

A taxa de inadimplência era alta, com 38% dos empréstimos potencialmente em risco. O competidor selecionou 34 das 77 características disponíveis, utilizando eliminações recursivas de características para aprimorar a precisão. O diferencial foi a otimização do limiar de decisão: ao invés de utilizar 0.5, um threshold de 0.35 maximizou a pontuação F1, aumentando significativamente a performance.

“Acho que a mudança de limiar foi o que fez a diferença entre o segundo lugar e a vitória.

(“I ended up maximizing the F1 score, which is the harmonic mean between precision and recall.”)— Competidor, FinTech

Esses resultados destacam a importância da compreensão do problema em vez da dependência excessiva de algoritmos complexos. Com o espaço de dados crescendo rapidamente, futuras pesquisas devem buscar maneiras de integrar conhecimento de domínio com técnicas de aprendizado de máquina, tornando modelos mais interpretáveis e aplicáveis na prática.

Fonte: (Towards Data Science – AI, ML & Deep Learning)