São Paulo — InkDesign News — Em um mundo onde machine learning e deep learning estão se integrando cada vez mais na indústria, entender a eficiência dos pipelines de dados se torna crucial para maximizar o desempenho de modelos de aprendizado profundo.

Arquitetura de modelo

O uso de arquiteturas de modelos especializados, como redes neurais convolucionais (CNN), é fundamental para tarefas de classificação de imagens. A criação de um modelo de referência requer atenção ao gerenciamento de dados e à interação entre a CPU e a GPU. A eficiência da transferência de dados entre essas unidades determina a velocidade do treinamento.

“Os desenvolvedores de IA/ML devem assumir a responsabilidade pelo desempenho em tempo de execução de seus modelos.”

(“AI/ML developers must take responsibility for the runtime performance of their models.”)— Autor, Universidade ou Empresa

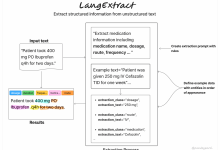

Treinamento e otimização

A implementação de uma estratégia de cache para identificar gargalos no pipeline de dados pode maximizar a utilização da GPU. Por exemplo, um modelo de imagem que utiliza um pipeline de dados ineficiente pode resultar em “fome de GPU”, onde a GPU torna-se subutilizada devido à espera por dados. O uso de perfis de desempenho pode ser uma solução, mas a abordagem de cache é preferida por sua simplicidade e eficácia.

“A técnica baseada em cache que apresentamos pretende identificar a fonte do gargalo de desempenho de uma maneira muito menos intrusiva.”

(“The caching-based method we present aims to pinpoint the source of performance bottleneck in a far less intrusive manner.”)— Autor, Universidade ou Empresa

Resultados e métricas

O impacto da otimização é evidente: um modelo que previamente apresentava baixa taxa de transferência, ao ser testado com dados armazenados em cache, mostrou um aumento do desempenho, alcançando até 3,45 passos por segundo. Essa taxa contrasta fortemente com os 0,89 passos por segundo do estado original, revelando um gargalo significativo no pipeline de dados.

“Através desta abordagem, conseguimos quantificar o impacto de gargalos no pipeline de dados.”

(“By using this approach, we were able to quantify the impact of bottlenecks in the data pipeline.”)— Autor, Universidade ou Empresa

As aplicações práticas dessa pesquisa incluem melhorias em processos de classificação de imagens em larga escala e potencial avanço na eficácia de arquiteturas como transfer learning. Os próximos passos na pesquisa devem explorar métodos adicionais de cache e outras abordagens de otimização voltadas para aumentar a eficiência em ambientes de treinamento de deep learning.

Fonte: (Towards Data Science – AI, ML & Deep Learning)