São Paulo — InkDesign News —

Pesquisadores do Massachusetts Institute of Technology (MIT) desenvolveram uma nova linguagem baseada em diagramas para otimizar modelos de deep learning. Este avanço promete simplificar a coordenação de sistemas complexos de IA, tornando o processo de otimização mais visual e sistemático.

Contexto da pesquisa

A pesquisa do MIT, conduzida no Laboratory for Information and Decision Systems (LIDS), foca em algoritmos de deep learning — base de modelos de inteligência artificial como grandes modelos de linguagem (LLMs) e geradores de imagens. Deep learning manipula dados por meio de múltiplas operações matriciais, atualizando bilhões de parâmetros durante o treinamento, o que torna o custo computacional elevado. A otimização destes modelos, considerando consumo energético e memória, é um desafio crítico para desenvolvimento eficiente.

“Desenvolvemos uma nova linguagem para falar sobre esses sistemas”

(“We designed a new language to talk about these new systems.”)— Gioele Zardini, Professor, MIT LIDS

Método proposto

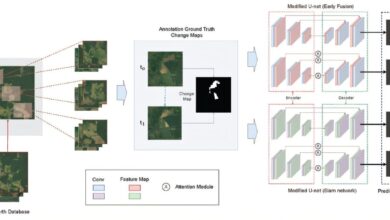

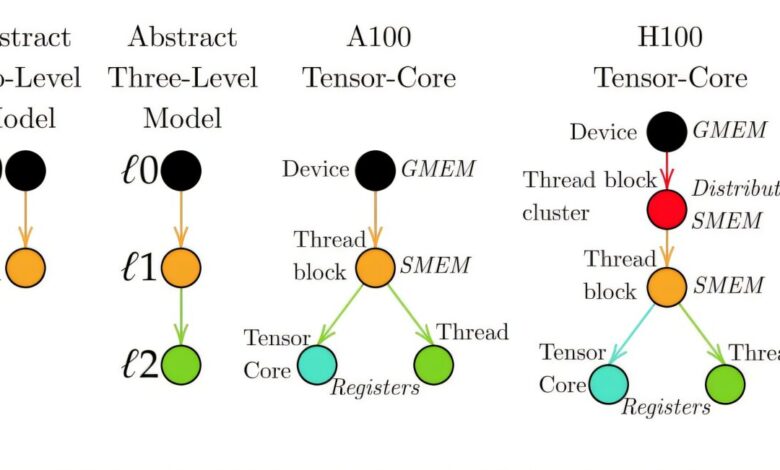

O método utiliza a teoria das categorias para representar os componentes dos algoritmos e suas interações em diagramas visuais, chamados “diagramas monoidais de cordas”. Essa abordagem permite mapear formalmente a arquitetura dos algoritmos, incluindo fatores como consumo de energia e alocação de memória. A novidade está em relacionar visualmente algoritmos com execução paralela em GPUs, facilitando a otimização de processos como a atenção (attention), fundamental para modelos de linguagem.

“Diagrams can both represent a function, and then reveal how to optimally execute it on a GPU.”

(“Em diagramas, é possível representar uma função e depois revelar como executá-la de forma ótima em uma GPU.”)— Vincent Abbott, Doutorando, MIT LIDS

Resultados e impacto

A aplicação da nova linguagem ao algoritmo FlashAttention, que otimizou a atenção em deep learning com ganho de até seis vezes em velocidade após quatro anos de desenvolvimento, mostrou que é possível derivar essa otimização de forma simples e rápida, “em um guardanapo”. A abordagem aumenta a clareza na relação entre algoritmo e consumo computacional, abrindo caminho para automação de descobertas de melhorias em software de IA.

“Este método permite que a otimização seja derivada muito rapidamente, em contraste com os métodos atuais.”

(“This method allows for optimization to be really quickly derived, in contrast to prevailing methods.”)— Vincent Abbott, Doutorando, MIT LIDS

O próximo passo envolve o desenvolvimento de software que detecte automaticamente melhorias em códigos enviados por pesquisadores, propondo versões otimizadas. A técnica também facilita o co-design entre hardware e software de sistemas computacionais.

A pesquisa, publicada na Transactions of Machine Learning Research, representa uma contribuição significativa para o campo do machine learning e deep learning, destacando a junção entre matemática abstrata e computação aplicada.

Fonte: (TechXplore – Machine Learning & AI)