Oxford — InkDesign News —

Pesquisadores da Universidade de Oxford têm revelado um crescimento expressivo no uso de ferramentas de inteligência artificial (IA) e machine learning acessíveis para a criação de deepfakes, modelos que geram imagens não consensuais de pessoas identificáveis, sobretudo mulheres.

Contexto da pesquisa

O estudo conduzido por Will Hawkins, doutorando do Oxford Internet Institute (OII), analisou cerca de 35 mil variantes de modelos deepfake disponíveis em plataformas públicas, especialmente no repositório Civitai. Essas variantes são versões refinadas de modelos de IA para gerar imagens manipuladas de pessoas, muitas vezes celebridades ou indivíduos menos expostos presentes em redes sociais. A investigação é relevante frente ao impacto social e legal da criação não autorizada de imagens íntimas, especialmente em contextos onde a legislação ainda está em desenvolvimento.

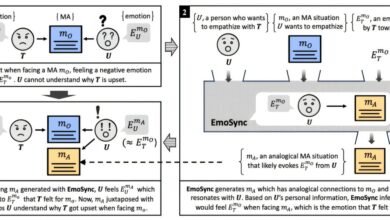

Método proposto

Os modelos exploram a técnica Low Rank Adaptation (LoRA), que permite a adaptação rápida de modelos deepfake a partir de apenas 20 imagens do indivíduo alvo. O processo pode ser realizado em computadores comuns em cerca de 15 minutos, facilitando o acesso a essas ferramentas. O foco do estudo foi analisar a escala do uso e os padrões de direcionamento dessas criações, usando análises quantitativas e qualitativas sobre os dados coletados das plataformas.

Resultados e impacto

Os dados indicaram que, desde novembro de 2022, as variantes de deepfake foram baixadas quase 15 milhões de vezes. Dos modelos estudados, 96% tinham como alvo mulheres, variando de figuras públicas a usuários comuns de países como China, Coreia, Japão, Reino Unido e Estados Unidos. Muitas variantes continham tags explicitamente associadas à criação de imagens íntimas não consensuais (NCII), violando termos de uso e leis vigentes, como as do Reino Unido.

“Há uma necessidade urgente de salvaguardas técnicas mais robustas, políticas de plataforma claras e aplicadas de forma proativa, além de novos enfoques regulatórios para combater a criação e distribuição desses modelos de IA prejudiciais.”

(“There is an urgent need for more robust technical safeguards, clearer and more proactively enforced platform policies, and new regulatory approaches to address the creation and distribution of these harmful AI models.”)— Will Hawkins, Doutorando, University of Oxford

A pesquisa destaca a inclusão recente da proibição criminal da distribuição de deepfakes sexuais na legislação de segurança online do Reino Unido e a tramitação legislativa para criminalizar sua criação. O estudo alerta que os modelos públicos podem ser apenas uma parte da problematização, visto que conteúdos mais ilícitos podem estar circulando em ambientes não públicos ou clandestinos.

As aplicações futuras incluem o desenvolvimento de tecnologias que identifiquem e bloqueiem conteúdos deepfake não consensuais e policiamento automatizado para cumprimento de legislações emergentes.

Fonte: (TechXplore – Machine Learning & AI)