Deep learning oculta códigos em luz para combater vídeos falsos

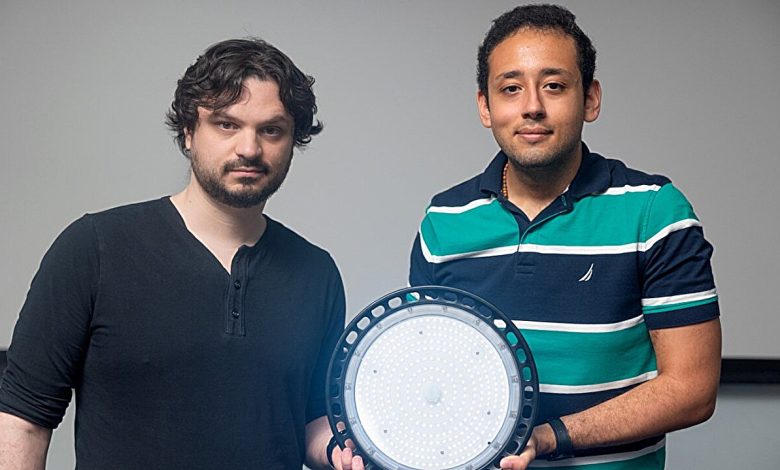

Pesquisadores da Universidade Cornell desenvolveram um método inovador utilizando machine learning para proteger vídeos contra manipulações e desinformação. O novo sistema “marca” a luz em cenas importantes, promovendo a integridade dos conteúdos visuais.

Contexto da pesquisa

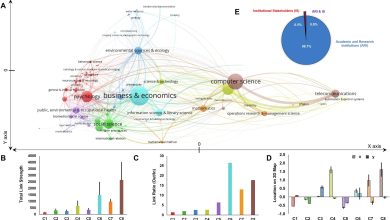

Com o crescimento do uso de IA para gerar vídeos manipulados, garantir a autenticidade desse material se tornou uma prioridade. A equipe da Cornell criou uma abordagem que rivaliza com métodos tradicionais de verificação de vídeos, uma vez que a manipulação de conteúdos audiovisuais está mais acessível.

Método proposto

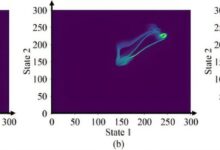

O sistema utiliza flutuações quase invisíveis na iluminação para codificar informações ocultas em vídeos. Essas flutuações, que vão imperceptíveis a olho nu, funcionam como uma “marca d’água” que pode ser detectada posteriormente. Cada fonte de luz possui um código secreto que, quando comparado ao vídeo capturado, pode identificar edições maliciosas.

“Mudanças nos vídeos manipulados começam a contradizer o que vemos nesses vídeos codificados, o que nos permite identificar onde ocorreram alterações.”

(“When someone manipulates a video, the manipulated parts start to contradict what we see in these code videos, which lets us see where changes were made.”)— Abe Davis, Professor Assistente, Cornell University

Resultados e impacto

Os pesquisadores demonstraram que é possível implementar até três códigos diferentes para várias fontes de luz na mesma cena, complicando ainda mais o processo de falsificação. O sistema foi testado em ambientes internos e externos, com resultados positivos em vídeos de diferentes tons de pele.

“Isso se torna uma tarefa muito mais desafiadora para quem tenta falsificar o conteúdo.”

(“Their job is still a lot harder.”)— Peter Michael, Estudante de Pós-Graduação, Cornell University

Os próximos passos da pesquisa incluem a investigação adicional sobre aplicações em outras áreas e melhorias na detecção de manipulações avançadas. O uso dessa tecnologia pode se estender a plataformas de notícias e redes sociais, onde a desinformação frequentemente compromete a verdade.

Fonte: (TechXplore – Machine Learning & AI)