Comunicações inovadoras melhoram o processo de treinamento de AI

São Paulo — InkDesign News —

Uma nova pesquisa na área de machine learning propõe uma solução inovadora para aumentar a eficiência no treinamento de grandes modelos de linguagem (LLMs). O estudo, desenvolvido na Universidade Rice, indica que uma nova abordagem de comunicação pode reduzir significativamente os gargalos no processo de aprendizado de máquina.

Contexto da pesquisa

O time de pesquisa, liderado pelo graduado doutoral Zhuang Wang e o professor de ciência da computação T.S. Eugene Ng, identificou dois pontos principais onde os LLMs enfrentam gargalos durante o treinamento distribuído. O primeiro está na fase de computação, onde a necessidade de processar grandes quantidades de dados consome tempo e poder computacional. Para combater isso, as equipes dividem os dados entre várias GPUs, permitindo que diversos samples de dados sejam processados simultaneamente.

Método proposto

Wang explicou que “o envio de todos os dados foi a solução anterior. Mas na prática, observamos que os dados contêm muitos valores zero nas ‘comunicações’.” (

fala traduzida

(“The previous solution was to send all the data out. But in practice, we observe that the data has a lot of zero values in the ‘talk’.”)— Zhuang Wang, Doutorando, Universidade Rice

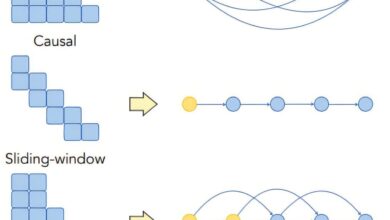

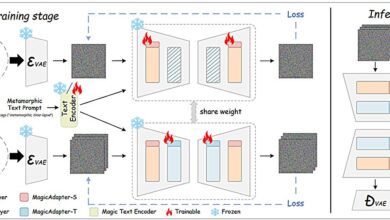

). A pesquisa propõe a “esparsificação”, onde apenas valores relevantes são mantidos durante a comunicação, resultando em “tensores esparsos”. Essa técnica, embora comum, ainda deixou o gargalo de comunicação, que a equipe abordou. Analisaram as características desses tensores em modelos populares para entender melhor sua distribuição e propor esquemas de comunicação otimizados.

Resultados e impacto

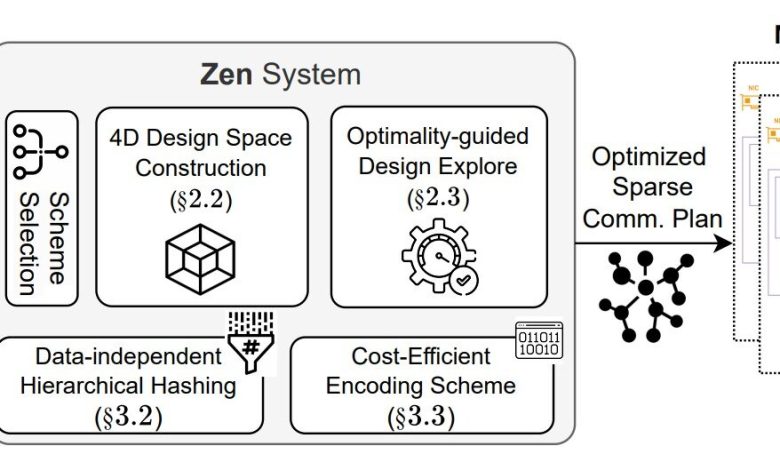

A terceira fase do projeto envolveu a construção de um sistema prático, o ZEN, que foi testado em condições reais de treinamento de LLMs. Ng comentou que “nós basicamente mostramos que podemos acelerar o tempo de conclusão do treinamento porque a comunicação é mais eficiente.” (

fala traduzida

(“What we basically show is that we can accelerate the time to completion of training because communication is more efficient.”)— T.S. Eugene Ng, Professor, Universidade Rice

). Os resultados indicaram uma melhora notável na velocidade de treinamento, com aplicabilidade em modelos que aliem características de esparsidade, seja em geração de texto ou imagem. A pesquisa foi apresentada na 19ª Simpósio da USENIX sobre Design e Implementação de Sistemas Operacionais (OSDI) em Boston.

As aplicações potenciais dessa nova abordagem são vastas, podendo impactar diversos campos onde modelos de aprendizado de máquina são utilizados. Estabelecendo uma nova norma para a eficiência em comunicação, a abordagem ZEN pode pavejar o caminho para aprimoramentos futuros em treinamento distribuído.

Fonte: (TechXplore – Machine Learning & AI)