São Paulo — InkDesign News — A crescente adoção de sistemas de machine learning e deep learning destaca a importância de avaliações específicas para garantir o desempenho em cenários do mundo real. Com um foco crescente em aplicações práticas, a necessidade de métricas eficazes torna-se essencial.

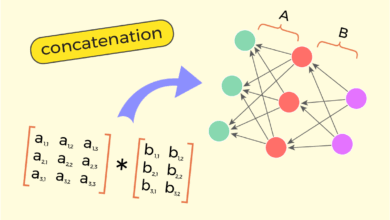

Arquitetura de modelo

A arquitetura de modelos baseados em deep learning é frequentemente avaliada através de benchmarks padronizados. Embora esses benchmarks, como MMLU, ajudem a estabelecer referências, eles frequentemente carecem de aplicabilidade em tarefas específicas. A dicotomia entre avaliação geral e específica pode afetar a confiança no desempenho em situações reais.

“Quando você pode medir o que está falando e expressá-lo em números, você sabe algo sobre isso; mas quando não consegue medir, … seu conhecimento é de um tipo medíocre e insatisfatório.”

(“When you can measure what you are speaking about, and express it in numbers, you know something about it; but when you cannot measure it, … your knowledge is of a meager and unsatisfactory kind.”)— Lord Kelvin

Treinamento e otimização

O treinamento e a otimização de modelos requerem avaliações contínuas para identificar problemas precocemente e guiar iterações. Avaliações baseadas em tarefas permitem refinamentos contínuos, garantindo que a performance em cenários práticos seja validada. É nesse processo que se estabelece a confiança na aplicabilidade dos modelos.

Resultados e métricas

As métricas de desempenho devem se alinhar com as expectativas de usuários e mercados. Em vez de focar apenas em resultados de benchmarks, as avaliações devem refletir as necessidades reais dos usuários. Isso não só proporciona validação, mas também fundamenta melhorias contínuas.

“As avaliações não são apenas sobre depuração ou QA; elas são o tecido conectivo entre protótipos e sistemas de produção que as pessoas podem confiar.”

(“Evaluations are how we make AI accountable. They’re not just for debugging or QA; they’re the connective tissue between prototypes and production systems that people can rely on.”)— Autor desconhecido

As avaliações adequadas são cruciais para definir o que significa “sucesso” em implementações de machine learning. À medida que a pesquisa avança, a integração de avaliações baseadas em tarefas pode se tornar um padrão em ciclos de desenvolvimento, tornando os sistemas mais adaptáveis e confiáveis.

O futuro das avaliações em deep learning parece promissor, com um enfoque na criação de métricas mais relevantes para o desempenho em condições do mundo real. Isso não só ajudará na validação de produtos, mas também pode influenciar regulamentações e confiança no uso de IA.

Fonte: (Towards Data Science – AI, ML & Deep Learning)