São Paulo — InkDesign News — As técnicas de machine learning estão evoluindo rapidamente, e o foco em métodos eficazes de engenharia de prompt é vital para a otimização de modelos de linguagem, como os baseados em deep learning.

Arquitetura de modelo

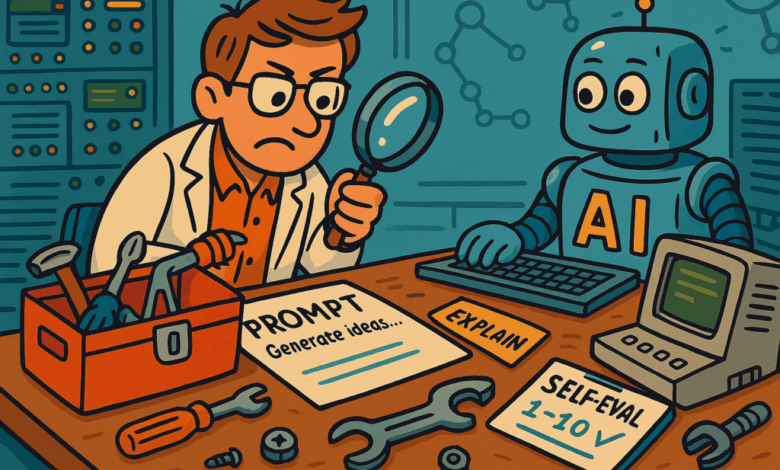

Modelos de linguagem grandes (LLMs) são construídos com arquiteturas complexas que permitem uma enorme capacidade de processamento. A estrutura inicial de um prompt pode ser influenciada ao pedir ao LLM que refine suas próprias instruções. Essa estratégia de "co-construção" resulta em prompts mais precisos e eficazes.

“A estrutura geral é composta por três etapas: Começar com uma estrutura geral explicando tarefas e regras a seguir; avaliação/referência iterativa do prompt para corresponder ao resultado desejado; e integração iterativa de casos limites ou necessidades específicas.”

(“The overall process is often composed of three steps: Start with general structure explaining tasks and rules to follow; Iterative evaluation/refinement of the prompt to match the desired result; Iterative integration of edge cases or specific needs.”)— Autor desconhecido

Treinamento e otimização

A autoavaliação é uma técnica que envolve solicitar que o LLM classifique a qualidade de suas respostas. Com base em uma escala de 1 a 10, respostas abaixo de um determinado limite são reavaliadas ou melhoradas. Essa abordagem mostra que os LLMs frequentemente tendem a gerar respostas mais simples, similar ao comportamento humano.

“Dar um padrão de qualidade explícito ajuda a melhorar significativamente o resultado final.”

(“Giving it an explicit quality standard helps significantly improve the final output result.”)— Autor desconhecido

Resultados e métricas

Dividir tarefas complexas em etapas simples pode manter a qualidade da resposta alta. Quando questionado para realizar múltiplas atividades simultâneas, como revisão, tradução e formatação, a qualidade tende a cair. Usar uma estrutura de resposta acompanhada de um exemplo focado em formato e conteúdo também é uma prática recomendada.

Práticas notáveis incluem a criação de exemplos bem escolhidos e a manutenção de uma estrutura coesa nas respostas, evitando a sobrecarga de informações que possa diluir instruções cruciais. Um ou dois exemplos claros, combinados com uma breve explicação, são geralmente suficientes para obter resultados otimizados.

“Os exemplos frequentemente são pesados em texto, e usar muitos pode diluir as regras mais importantes.”

(“Examples are often text-heavy, and using too many of them can dilute the most important rules.”)— Autor desconhecido

Para o futuro, técnicas de engenharia de prompt eficazes são essenciais em cenários de produção, possibilitando uma interação mais precisa e intuitiva com LLMs. As aplicações práticas dessas estratégias podem impactar significativamente a forma como utilizamos modelos de deep learning em tarefas do dia a dia.

Fonte: (Towards Data Science – AI, ML & Deep Learning)