São Paulo — InkDesign News — No universo da inteligência artificial, iniciativas que conectam machine learning e interações humanas estão se popularizando. Recentemente, um projeto destacou-se ao combinar agentes múltiplos com ferramentas interativas, otimizando a facilidade de consulta em bancos de dados.

Arquitetura de modelo

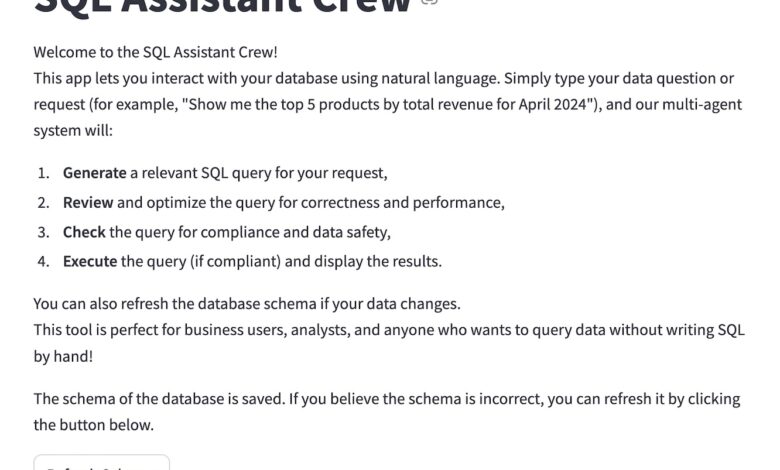

O sistema desenvolvido utiliza uma arquitetura composta por três agentes básicos: o Query Generator Agent, que transforma perguntas em linguagem natural em consultas SQL; o Query Reviewer Agent, que revisa e otimiza as consultas geradas; e o Compliance Checker Agent, encarregado de verificar a conformidade das consultas para evitar a exposição de informações sensíveis.

“Decidi construir um assistente que gerasse consultas SQL de forma prática, dinâmico e seguro”

(“I decided to build an assistant that would generate SQL queries based on natural language.”)— Autor, Data Analyst

Treinamento e otimização

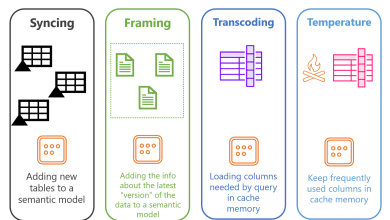

Os agentes são impulsionados pelo modelo de linguagem openai/gpt-4o-mini e utilizam parâmetros ajustáveis como temperatura e max_tokens para garantir resultados consistentes, reduzindo as alucinações do modelo. Um ponto chave na implementação é a verificação humana durante o processo, permitindo que usuários reavaliem as consultas geradas antes da execução.

“A adição de um verificador humano garante que os usuários mantenham controle e transparência nas consultas”

(“The addition of a human checker ensures users maintain control and transparency over the queries.”)— Autor, Data Analyst

Resultados e métricas

Os resultados foram promissores, permitindo que usuários interagissem com um banco de dados SQLite por meio de comandos em linguagem natural. A aplicação foi testada com exemplos práticos, mostrando um custo de uso do modelo LLM que variou significativamente dependendo da complexidade da consulta, com gastos mínimos registrados em processos bem-sucedidos. A implementação inclui rastreamento de custos baseados em tokens consumidos, gerando maior preocupação com a eficiência financeira.

“Para a maioria das interações, o custo foi considerado baixo, apontando para um sistema viável para uso industrial”

(“For most interactions, the cost was deemed low, pointing towards a viable system for industrial use.”)— Autor, Data Analyst

Esse desenvolvimento tem aplicações práticas no atendimento a consultas em larga escala, principalmente em setores onde decisões rápidas baseadas em dados são cruciais. O próximo passo envolve a exploração de modelos de recuperação aumentada para gerenciar interações com bancos de dados ainda mais complexos, utilizando RAG (Retrieval Augmented Generation) para fornecer contextos mais relevantes às consultas.

Fonte: (Towards Data Science – AI, ML & Deep Learning)