AI exige ação urgente: gigantes da tecnologia alertam sobre riscos

Contexto da pesquisa

A evolução da machine learning tem trazido grandes benefícios, mas também levanta sérias questões de segurança. Recentemente, líderes de empresas como Google DeepMind, OpenAI e Meta, junto a pesquisadores, solicitaram mais atenção para o monitoramento do raciocínio das AI.

Método proposto

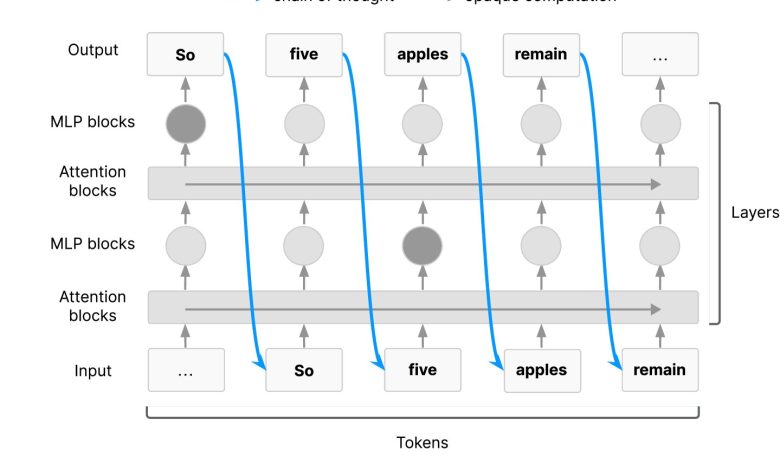

No estudo, os cientistas enfatizam a importância da técnica “chains-of-thought” (CoTs) como ferramenta para resolver problemas complexos. Essa abordagem permite que modelos de AI façam o raciocínio por meio de etapas menores, similar ao que humanos fazem em tarefas difíceis. “O monitoramento da cadeia de pensamento apresenta uma valiosa adição às medidas de segurança para AI de ponta, oferecendo uma rara visão sobre como os agentes de AI tomam decisões” (“Chain of thought monitoring presents a valuable addition to safety measures for frontier AI, offering a rare glimpse into how AI agents make decisions.”) — Pesquisadores, Vários, Instituições participantes.

Resultados e impacto

A pesquisa, apresentada em um artigo recente, destaca como o monitoramento das CoTs já detectou comportamentos inadequados de modelos, revelando potenciais falhas nos sistemas de AI. A publicação solicita que desenvolvedores estudem o que torna as CoTs monitoráveis e como essa compreensão pode ser integrada como uma medida de segurança.

O estudo sugere que a melhoria no monitoramento das CoTs pode ser vital para controlar agentes de AI à medida que se tornam mais avançados. Como a precisão dos modelos é avaliada, métricas de desempenho são essenciais. Ao analisar datasets diversos e benchmarks de performance, os pesquisadores buscam entender melhor a eficácia dessas abordagens.

Com os sistemas de AI se tornando cada vez mais potentes, os próximos passos incluem a expansão do monitoramento e a implementação das diretrizes discutidas para garantir segurança e responsabilidade na aplicação dessas tecnologias.

Fonte: (TechXplore – Machine Learning & AI)