São Paulo — InkDesign News — Um novo alerta para a segurança cibernética destaca como os controles fundamentais e estratégias de modelagem de ameaças podem fortalecer a segurança de ferramentas de IA autônomas, abordando lacunas que os guardrails tradicionais não conseguem preencher.

Vetor de ataque

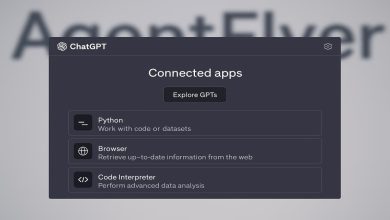

Recentemente, David Brauchler III, da NCC Group, enfatizou que a abordagem tradicional de segurança pode não ser suficiente para proteger ferramentas de IA agente. A falta de controles eficazes pode expor essas tecnologias a vetores de ataque sofisticados. Brauchler comenta que “os sistemas de IA precisam de uma defesa mais robusta, pois as falhas são frequentemente exploradas de maneiras não convencionais” (“AI systems require a more robust defense, as vulnerabilities are often exploited in unconventional ways”).

Impacto e resposta

As falhas exploradas podem permitir ataques como a manipulação de dados, onde agentes maliciosos comprometem o funcionamento da IA. Além disso, a possibilidade de um ataque zero-day representa um risco considerável, pois pode haver meses ou até anos entre a exploração de uma vulnerabilidade e a sua recuperação. Esse cenário aumenta a necessidade de uma vigilância contínua e atualizações regulares de segurança.

Análise e recomendações

A análise e a implementação de controles arquiteturais são vitais. Brauchler recomenda incorporar práticas de modelagem de ameaças desde o início do ciclo de desenvolvimento, permitindo identificar lacunas e priorizar a mitigação efetiva. O uso de ferramentas de automação e inteligência artificial para detectar anomalias pode ser uma estratégia útil para fortalecer as defesas.

Com a evolução das ameaças cibernéticas, espera-se que as empresas implementem protocolos mais rigorosos e invistam em tecnologias inovadoras para prevenir possíveis brechas em suas ferramentas de IA. O fortalecimento da segurança nesse campo emergente será crucial para proteger dados e operações empresariais.

Fonte: (Dark Reading – Segurança Cibernética)