São Paulo — InkDesign News —

Pesquisadores do MIT descobriram que modelos de aprendizado de linguagem e visão (VLM) não conseguem lidar adequadamente com consultas que contêm palavras de negação, o que pode levar a diagnósticos errôneos em aplicações críticas.

Contexto da pesquisa

Em um estudo recente, os cientistas analisaram como os modelos VLM interpretam palavras de negação, como “não” e “sem”. A pesquisa destaca preocupações sobre a precisão desses modelos ao serem utilizados em cenários de alta importância, como diagnóstico médico e controle de qualidade na manufatura.

“Essas palavras de negação podem ter um impacto significativo, e se estivermos apenas usando esses modelos cegamente, podemos ter consequências catastróficas.”

(“Those negation words can have a very significant impact, and if we are just using these models blindly, we may run into catastrophic consequences.”)— Kumail Alhamoud, Estudante de Pós-Graduação, MIT

Método proposto

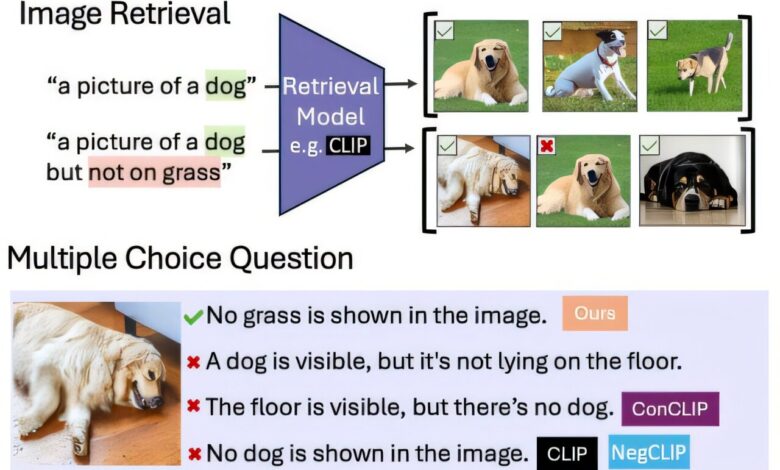

A equipe desenvolveu um dataset com 10 milhões de pares de imagens e legendas que incluem palavras de negação. Este treinamento ajudou os VLMs a identificar o que não estava presente nas imagens. Para testar a capacidade dos modelos em entender negações, eles foram submetidos a duas tarefas: recuperação de imagens com base em legendas negadas e perguntas de múltipla escolha que incluíam opções com e sem referências a objetos ausentes.

Resultados e impacto

Os resultados mostraram que os modelos falharam em ambas as tarefas, apresentando uma queda de quase 25% na recuperação de imagens quando legendas negadas foram utilizadas. O melhor desempenho em perguntas de múltipla escolha alcançou apenas 39% de precisão, com muitos modelos performando abaixo da chance aleatória. A equipe observou um viés de afirmação, onde as VLMs ignoraram palavras de negação, focando apenas nos objetos visíveis nas imagens.

“Independentemente de como você expressa negação ou exclusão, os modelos simplesmente a ignoram.”

(“Regardless of how you express negation or exclusion, the models will simply ignore it.”)— Kumail Alhamoud, Estudante de Pós-Graduação, MIT

Este estudo sugere que, ao integrar técnicas de aprendizado de máquina mais sofisticadas, os pesquisadores podem desenvolver modelos que processam texto e imagem separadamente, melhorando a compreensão de negações. O trabalho destaca uma necessidade urgente de avaliação cuidadosa antes do uso desses modelos em aplicações críticas.

Fonte: (TechXplore – Machine Learning & AI)