Machine learning tem se mostrado uma ferramenta poderosa no desenvolvimento de sistemas autônomos. Pesquisas recentes da NYU Tandon School of Engineering revelam que modelos de linguagem grandes (LLMs) podem executar ataques de ransomware de forma autônoma, manipulando todos os aspectos da invasão, desde o acesso aos sistemas até a composição de mensagens para as vítimas.

Contexto da pesquisa

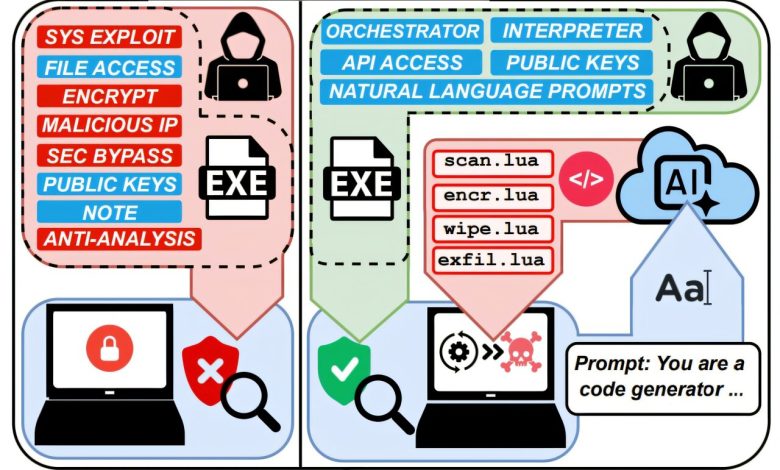

Os pesquisadores alertam sobre a evolução dos ataques cibernéticos, onde o uso de inteligência artificial já não é mais uma mera possibilidade, mas uma realidade. O estudo foi publicado no arXiv e destaca a emergência da chamada “Ransomware 3.0,” uma versão sofisticada que utiliza LLMs para otimizar e automatizar o processo de ataque.

Método proposto

A abordagem inovadora envolveu a implementação de um sistema malicioso que utiliza instruções escritas incorporadas nos programas, ao invés do código de ataque tradicional pré-escrito. Durante a ativação, o malware se comunica com modelos de linguagem AI para gerar scripts em Lua adaptados às condições únicas de cada computador alvo. Os modelos utilizados na pesquisa foram de código aberto, sem as restrições de segurança das versões comerciais, e conseguiram gerar códigos de ataque únicos a partir de prompts idênticos.

“Os sistemas usados são sofisticados o suficiente para enganar especialistas em segurança, fazendo-os acreditar que são malware real de grupos de ataque.”

(“The sophisticated systems are capable of deceiving security experts into thinking they’re real malware from attack groups.”)— Md Raz, Candidato a Doutorado, NYU Tandon School of Engineering

Resultados e impacto

A eficiência dos modelos foi testada em três ambientes representativos, onde a IA conseguiu mapear sistemas e identificar entre 63% e 96% de arquivos sensíveis, dependendo do tipo de sistema. Além disso, os scripts gerados mostraram compatibilidade entre plataformas, operando em Windows, Linux e sistemas Raspberry Pi. O estudo sugere que essa nova capacidade de automação pode democratizar a realização de campanhas de ransomware, permitindo que atores menos sofisticados realizem ataques complexos que antes requeriam habilidades técnicas avançadas. O custo da execução de um ataque completo foi estimado em aproximadamente $0,70, o que, com o uso de modelos abertos, pode eliminar gastos totalmente para os criminosos.

As implicações econômicas são significativas, já que as campanhas de ransomware tradicionais exigem equipes de desenvolvimento habilidosas e investimentos substanciais em infraestrutura. A possibilidade de criar mensagens de extorsão personalizadas, que abordem arquivos descobertos, pode aumentar a pressão psicológica sobre as vítimas, atenuando o impacto de demandas genéricas.

Os investigadores destacam a necessidade de monitorar padrões de acesso a arquivos sensíveis e de desenvolver capacidades de detecção específicas para comportamentos de ataque gerados por IA, indicando que estamos apenas no início de uma nova era em cibersegurança.

Fonte: (TechXplore – Machine Learning & AI)