São Paulo — InkDesign News —

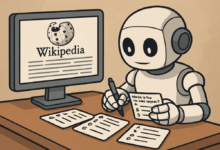

Nos últimos meses, o cenário de machine learning tem avançado rapidamente, especialmente com a introdução de novos modelos de LLMs (Large Language Models). A crescente variedade de modelos levanta questões sobre como efetivamente avaliá-los em diferentes situações.

Arquitetura de modelo

Os recentes lançamentos, como os modelos Qwen3, GPT-5 e Grok 4, têm se destacado em benchmarks populares, como o “Humanities Last Exam” e o “SWE-bench”. Entretanto, essa dependência de benchmarks conhecidos pode levar a limitações, uma vez que as empresas que os desenvolvem têm uma forte motivação para otimizar seus modelos nesse contexto.

“Esses benchmarks têm um erro inerente: as companhias liberando novos modelos estão incentivadas a otimizar seus algoritmos para a performance nesses benchmarks.”

(“However, these benchmarks have an inherent flaw: The companies releasing new front-end models are strongly incentivized to optimize their models for such performance on these benchmarks.”)— Autor, Especialista em LLMs

Treinamento e otimização

Uma abordagem sugerida para mitigar esses desafios é o desenvolvimento de benchmarks internos personalizados. Um diferencial importante é que esses benchmarks devem focar em tarefas que são menos comuns ou em dados que não estão disponíveis publicamente, garantindo que os modelos não tenham sido treinados especificamente para essas situações.

“Você deve desenvolver um benchmark interno para testar novos LLMs e descobrir quais funcionam melhor para seu caso de uso específico.”

(“Thus, you should develop an internal benchmark to properly test newly released LLMs and figure out which ones work best for your specific use case.”)— Autor, Especialista em LLMs

Resultados e métricas

Na construção deste novo benchmark, algumas diretrizes precisam ser seguidas. A avaliação deve ser automatizada sempre que possível, gerando uma pontuação numérica que permite ranquear os modelos testados. Exemplos de casos de uso incluem desenvolvimento em linguagens de programação raramente empregadas ou chatbots internos de perguntas e respostas, onde a eficácia da resposta é diretamente comparada ao resultado esperado.

Além de manter os benchmarks atualizados, é crucial evitar a contaminação dos dados de teste, já que os modelos atuais poderão acessar informações da internet durante seu treinamento.

Em conclusão, a evolução no campo de machine learning é rápida, e a necessidade de metodologias de teste mais robustas e personalizadas se torna cada vez mais evidente. A implementação de benchmarks internos não só pode otimizar o processo de avaliação, mas também garantir a eficácia na aplicação prática dos modelos de LLM.

Fonte: (Towards Data Science – AI, ML & Deep Learning)