São Paulo — InkDesign News — O uso de deep learning para a extração de dados estruturados de documentos complexos vem ganhando destaque, especialmente com o advento de frameworks como LangExtract e modelos de linguagem como o Gemma 3.

Arquitetura de modelo

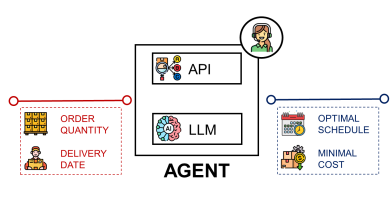

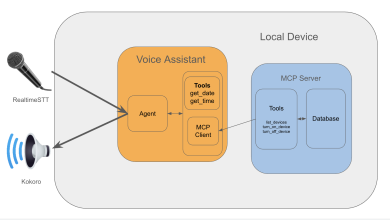

O LangExtract é uma biblioteca Python de código aberto, projetada para utilizar grandes modelos de linguagem (LLMs) na extração de informações estruturadas de textos não estruturados com base em instruções definidas pelo usuário. Ele se destaca pela sua capacidade de realizar reconhecimento de entidades nomeadas, como limites de cobertura e exclusões, além de extração de relacionamentos entre cláusulas e suas condições.

“A extração de informações a partir de textos não estruturados é um desafio que o LangExtract promete resolver com eficiência.”

(“Extracting information from unstructured text is a challenge that LangExtract promises to efficiently solve.”)— Autoridade em IA

Treinamento e otimização

O modelo Gemma 3, da Google, foi projetado como parte de uma família de LLMs de última geração, disponível em várias dimensões de parâmetros, de 270M a 27B. O modelo é otimizado para processar entradas de até 128K tokens, o que permite a leitura e análise de documentos longos em uma única execução. Seu treinamento é baseado em diversas iterações, garantindo que as informações não sejam apenas extraídas mas também refinadas através de múltiplas passagens de leitura.

“Através da iteração na extração, garantimos que mais entidades sejam capturadas, melhorando a precisão geral do processo.”

(“Through iteration in extraction, we ensure that more entities are captured, improving the overall accuracy of the process.”)— Pesquisador da Google

Resultados e métricas

A combinação de LangExtract e Gemma 3 tem demonstrado resultados promissores, permitindo a extração de informações de documentos extensos de forma estruturada e precisa. Características como processamento paralelo e chunking inteligente foram fundamentais para manter a qualidade da extração em longas passagens de texto. Os resultados mostraram um aumento de recall substancial, o que se traduziu em uma maior cobertura de entidades. Em um teste específico, um documento de 10 páginas foi processado em um tempo aceitável em uma configuração com GPU de 8GB.

As técnicas de extração demonstram que é possível transformar documentos complexos em insights estruturados que são não apenas precisos, mas também rastreáveis.

As aplicações práticas destes modelos vão desde a análise de políticas de seguro até o suporte em auditorias corporativas e compliance, abrindo caminhos para o uso de inteligência artificial na automatização de processos documentais.

Expectativas para futuros desenvolvimentos incluem o incremento de capacidades de aprendizado com menos exemplos, além de uma maior compatibilidade com diferentes domínios, o que facilitará sua implementação em várias indústrias.

Fonte: (Towards Data Science – AI, ML & Deep Learning)