São Paulo — InkDesign News — A inclusão de novas metodologias para avaliação de modelos de inteligência artificial (IA), especialmente em aplicações de processamento de linguagem natural, tem sido essencial para otimizar a escolha de LLMs (Large Language Models) em ambientes empresariais. O recente projeto "Inclusion Arena" propõe uma nova abordagem para a medição de desempenho dessas tecnologias, destacando a relevância de avaliações em cenários reais.

Tecnologia e abordagem

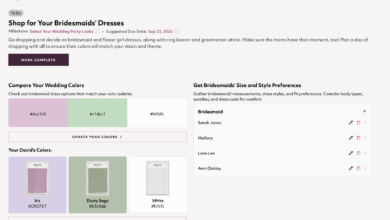

A inclusão do modelo de leaderboard Inclusion Arena, desenvolvido por pesquisadores da Inclusion AI, busca superar limitações dos benchmarks tradicionais, que frequentemente são baseados em conjuntos de dados estáticos. A proposta envolve avaliações em tempo real que refletem as preferências dos usuários em interações reais. A metodologia emprega o modelo Bradley-Terry, amplamente utilizado em comparações de desempenho, permitindo uma análise mais precisa das capacidades dos modelos em condições práticas.

“Para abordar essas lacunas, propomos o Inclusion Arena, um leaderboard ao vivo que conecta aplicações de IA com modelos LLMs e MLLMs de última geração.”

(“To address these gaps, we propose Inclusion Arena, a live leaderboard that bridges real-world AI-powered applications with state-of-the-art LLMs and MLLMs.”)— Pesquisadores da Inclusion AI

Aplicação e desempenho

A estrutura do Inclusion Arena é implementada em aplicativos de IA, como o Joyland e o T-Box. Durante o uso desses aplicativos, os usuários interagem com múltiplos LLMs sem saber qual modelo gerou a resposta, promovendo uma comparação justa. A partir das escolhas dos usuários, o algoritmo de Bradley-Terry calcula um escore para cada modelo, resultando em um ranking que se adapta à dinâmica de uso real.

Os primeiros resultados mostram que o modelo mais eficaz até agora é o Claude 3.7 Sonnet, seguido por outras versões desenvolvidas pela Anthropic e DeepSeek. Essa análise inicial abrangeu 501.003 comparações, destacando a eficácia da metodologia na identificação de modelos superiores.

Impacto e mercado

A necessidade de benchmarks mais dinâmicos é crescente, especialmente à medida que novas LLMs são desenvolvidas. O Inclusion Arena não apenas cria uma base mais robusta para avaliações, mas também permite que empresas realizem decisões mais informadas sobre quais modelos implantar em suas operações. A inclusão de estratégias como o mecanismo de correspondência de posicionamento e amostragem de proximidade representa um avanço significativo, já que facilita a comparação entre modelos em um número crescente.

A avaliação contínua através de dados em tempo real permitirá ajustes nas estratégias de implementação de IA, levando as empresas a um uso mais eficaz dessas tecnologias.

Em resumo, o Inclusion Arena sinaliza uma nova era na avaliação de modelos de IA, ligada diretamente ao desempenho e satisfação do usuário em cenários práticos.

Fonte: (VentureBeat – AI)