Estudo Revela Falhas do ChatGPT em Identificar Artigos Retirados

Uma pesquisa recente destaca os desafios que modelos de machine learning, como o ChatGPT, enfrentam na detecção de artigos acadêmicos reprovados ou descreditados, lançando luz sobre a integridade científica no uso de IA.

Contexto da pesquisa

A nova pesquisa, co-autorada pelo Professor Mike Thelwall e pela Dr. Irini Katsirea, foi publicada na revista Learned Publishing. O projeto, denominado “Ciência não confiável: desvendando o impacto da má representação na mídia”, começou em outubro de 2024 e busca investigar a precisão das ferramentas de IA em avaliar a qualidade de publicações científicas.

Método proposto

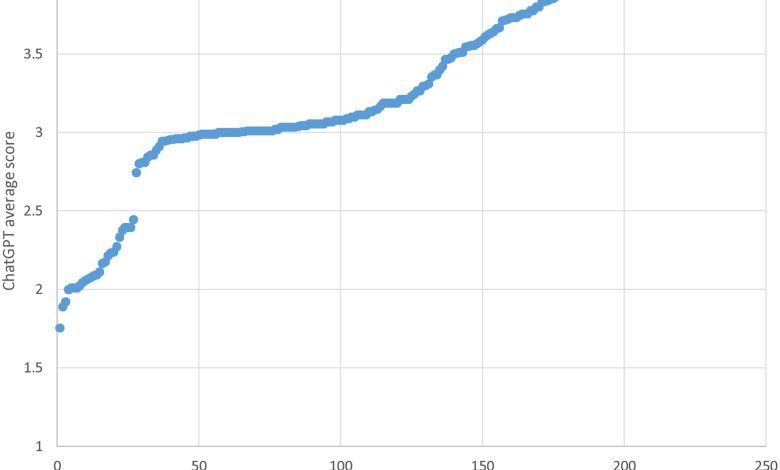

Os pesquisadores analisaram 217 estudos acadêmicos reprovados ou considerados problemáticos, todos com altas pontuações altmétricas. O ChatGPT foi solicitado a avaliar esses estudos 30 vezes cada, resultando em uma total de 6.510 relatórios. A abordagem consistiu em aplicar modelos de linguagem de aprendizado profundo, utilizando análises geradas por LLMs (Modelos de Linguagem de Grande Escala).

Resultados e impacto

A pesquisa revelou que em nenhuma das avaliações o ChatGPT mencionou que os artigos estavam reprovados ou tinham erros relevantes. Das avaliações, 190 artigos receberam pontuações relativamente altas, indicando que eram considerados de excelência internacional. As críticas que o modelo apresentou para os artigos de menor pontuação se restringiram a fraquezas acadêmicas, sem abordar questões de retação. Em cinco casos, o modelo descreveu o tema dos artigos como “controverso” (“controversial”).

“Os resultados do estudo foram uma surpresa e a incapacidade do ChatGPT de identificar pesquisas reprovadas é preocupante. Espero que as constatações ajudem aqueles que constroem esses sistemas a aprimorá-los. Também espero que a pesquisa sirva como um alerta adicional aos usuários para evitar confiar em sistemas de IA gerativa, mesmo quando parecem plausíveis e informados.”

(“The results of the study came as a surprise and the inability of ChatGPT to identify retracted research is concerning. I hope that the findings help those building these systems to improve them. I also hope that the research gives an additional warning to users to avoid trusting generative AI systems, even when they sound plausible and informed.”)— Mike Thelwall, Professor, Universidade de Sheffield

Esses achados tornam evidente a necessidade de verificar informações provenientes de sistemas de IA ao realizar buscas ou análises acadêmicas.

Para mais informações sobre machine learning e suas implicações, acesse nossa seção dedicada aqui.

Fonte: (TechXplore – Machine Learning & AI)