São Paulo — InkDesign News — Pesquisadores da Universidade de Harvard exploram as nuances da inteligência artificial (IA) e do aprendizado de máquina (machine learning), questionando se essas tecnologias realmente “entendem” o mundo como os humanos.

Contexto da pesquisa

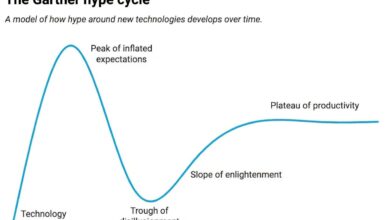

O debate sobre o que significa entender tem se intensificado com o avanço dos modelos de IA generativa. A perspectiva do filósofo Hilary Putnam, que compara uma formiga que traça um caminho na areia a uma suposta criação de uma imagem, levanta questões sobre a verdadeira capacidade de entendimento das máquinas.

Método proposto

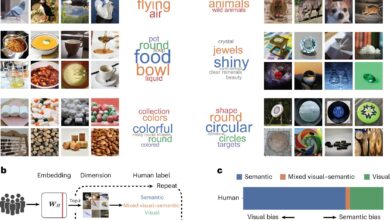

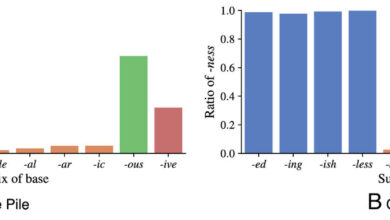

Pesquisadores, como Keyon Vafa, utilizam redes neurais—modelos computacionais que processam dados em camadas de neurônios inspiradas no cérebro humano. Um exemplo é a aplicação de modelos de aprendizado profundo em imagens médicas, onde é necessário reconhecer a presença de tumores. Os modelos são alimentados com conjuntos de dados que incluem imagens com e sem tumores, ajustando pesos até que consigam fazer previsões precisas.

“Os modelos de linguagem grande (LLMs) podem responder a perguntas, mesmo que não tenham visto aqueles exemplos antes, sugerindo que têm um modelo de mundo eficaz.”

(“Large language models (LLMs) can answer questions they presumably haven’t seen before, suggesting they have an effective world model.”)— Keyon Vafa, Pesquisador Pós-Doutoral, Harvard Data Science Initiative

Resultados e impacto

A pesquisa revela que, embora os modelos possam produzir resultados convincentes, como identificar direções precisas na cidade de Manhattan, eles frequentemente carecem de uma coerência subjacente. Em um experimento, uma IA gerou mapas inconsistentes, demonstrando que a máquina não possui uma compreensão real do espaço, mas sim memoriza e aplica regras de forma prática.

“Em muitos casos, a IA está essencialmente reconstruindo o mapa toda vez que você faz uma mudança. Isso sugere que falta uma concepção coesa da realidade.”

(“In many cases, the AI is essentially reconstructing the map every time you make a turn. This suggests a lack of coherent conception of reality.”)— Keyon Vafa, Pesquisador Pós-Doutoral, Harvard Data Science Initiative

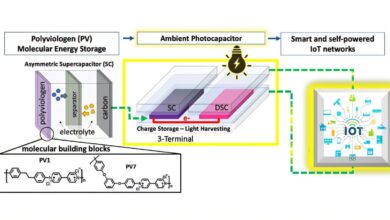

O CEO da OpenAI, Sam Altman, acredita que o desenvolvimento da inteligência geral artificial (AGI) está próximo. Vafa, por sua vez, busca entender como medir a qualidade dos modelos de mundo da IA, o que é crucial para avanços nesse campo. Os resultados dessas investigações podem impactar diversas áreas, como a identificação de doenças raras, independentemente da capacidade da IA de “entender” quals coisas.

Fonte: (TechXplore – Machine Learning & AI)