LLM ajuda na escolha entre texto e código para resolver problemas

São Paulo — InkDesign News —

A pesquisa recente realizada por cientistas do MIT revela um avanço significativo no campo de machine learning, especialmente na habilidade dos modelos de linguagem (LLMs) em decidir entre o uso de raciocínio textual e código para resolver problemas complexos.

Contexto da pesquisa

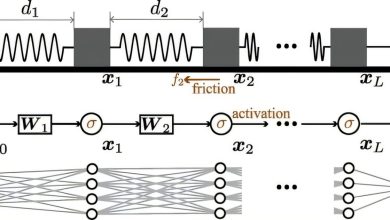

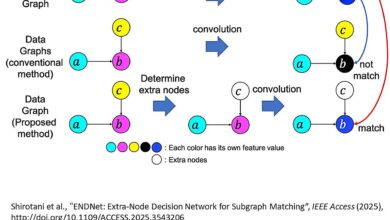

Os grandes modelos de linguagem têm se destacado na compreensão de contextos e elaboração de respostas lógicas, mas frequentemente falham em resolver problemas matemáticos simples. Embora esses modelos possam gerar código, como Python, para lidar com consultas simbólicas, eles não conseguem determinar quando e que tipo de código utilizar. A solução proposta envolve um assistente inteligente, denominado CodeSteer, que guia os LLMs a alternar entre texto e código até que uma resposta correta seja alcançada.

Método proposto

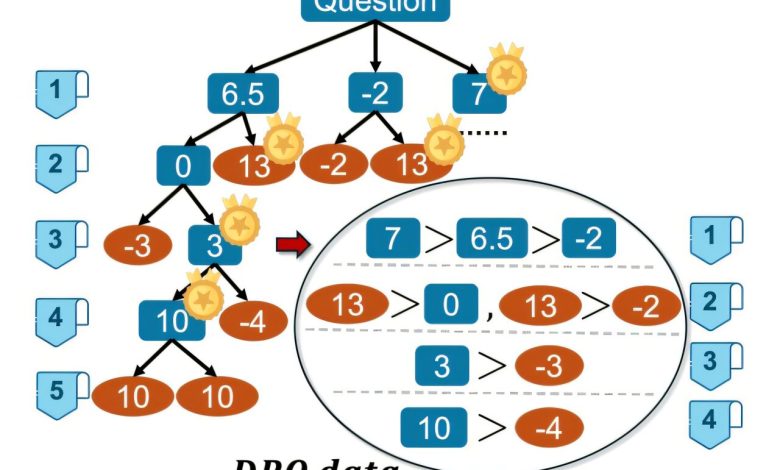

CodeSteer é um modelo de linguagem menor que gera uma série de prompts para orientar um LLM maior. Após cada rodada de interações, CodeSteer avalia as respostas do modelo, oferecendo dicas sobre como corrigir ou aprimorar a solução até que um resultado satisfatório seja alcançado. O método foi fundamentado em uma nova abordagem de fine-tuning que se utiliza de um repositório de 37 tarefas simbólicas complexas, chamado SymBench, para testar e ajustar o modelo.

“Nós inspiramos nossa abordagem em humanos. Em esportes, um treinador pode não ser melhor que o atleta principal, mas pode oferecer sugestões valiosas”

(“We were also inspired by humans. In sports, a trainer may not be better than the star athlete on the team, but the trainer can still give helpful suggestions to guide the athlete.”)— Yongchao Chen, Estudante de Pós-Graduação, MIT

Resultados e impacto

O uso do CodeSteer resultou em um aumento na acuracidade de tarefas simbólicas em mais de 30%, passando de 53,3% para 86,4%. Além disso, mesmo modelos menos sofisticados, quando potencializados com CodeSteer, superaram modelos avançados de raciocínio. Isso sugere que a colaboração entre diferentes modelos pode resultar em aplicações mais robustas e versáteis em cenários do mundo real. As métricas indicam que a abordagem não apenas maximiza a performance em tarefas conhecidas, mas também mantém a eficácia em tarefas não vistas.

“Este método utiliza as capacidades do próprio LLM. Ao agregar ao LLM a habilidade de usar código de forma inteligente, podemos melhorar ainda mais seu desempenho”

(“Our method uses an LLM’s own capabilities. By augmenting an LLM with the ability to smartly use coding, we can take a model that is already very strong and improve its performance even more.”)— Yongchao Chen, Estudante de Pós-Graduação, MIT

No futuro, os pesquisadores pretendem agilizar o processo iterativo de prompting do CodeSteer e explorar a possibilidade de criar um modelo unificado que transite entre raciocínio textual e geração de código sem a necessidade de um assistente separado.

Fonte: (TechXplore – Machine Learning & AI)